FAQ: Apple’s functies tegen kindermisbruik; privacygevaar of noodzakelijk kwaad?

Update 7 december 2022: Apple is definitief gestopt met de plannen om CSAM op te sporen.

Update 3 september 2021: Apple stelt de CSAM-maatregelen een paar maanden uit na kritiek van beveiligingsexperts en feedback van gebruikers.

Apple zet zich al jarenlang in voor de privacy van gebruikers. Dat is dan ook voor veel mensen een reden om voor de iPhone te kiezen, omdat Apple belooft nooit mee te kijken met je berichten, foto’s en je locatie niet volgt en weet waar je uithangt. De aangekondigde maatregelen voor het beschermen van kinderen lijkt daarmee in strijd te zijn. Er is dan ook veel kritiek op de maatregelen, niet alleen van gebruikers. Ook beveiligingsexperts zeggen dat Apple met deze maatregelen de deur op een kier zet voor een verregaande inbreuk op de privacy van gebruikers. Maar hoe zit het nieuwe systeem nou echt in elkaar? En wat zijn de gevaren voor jouw eigen privéfoto’s, bijvoorbeeld van je kinderen? In deze FAQ over Apple’s aankomende CSAM-detectie hopen we wat meer duidelijkheid te scheppen door de feiten aan je voor te leggen en tegelijkertijd de kritiek onder de aandacht te brengen.

- Wat gaat Apple precies doen?

- Wat doen andere bedrijven?

- Is dit nieuw, of gebeurde het al langer bij Apple?

- Treft dit alle gebruikers?

- Gaat Apple al mijn foto’s scannen?

- Waarom is dit potentieel gevaarlijk?

- Ziet Apple al mijn foto’s in de bibliotheek?

- Zijn de foto’s van mijn kinderen veilig?

- Is dit systeem waterdicht?

- Kan ik dit uitzetten?

- Kritiek en privacy

- Achterdeur

- Wat zijn de gevolgen voor de toekomst?

- Welke acties zijn er al gestart tegen Apple?

- Hoe reageert Apple op alle ophef?

#1 Wat gaat Apple precies doen?

Apple heeft officieel aangekondigd dat er in de Verenigde Staten meerdere maatregelen geïntroduceerd worden om kindermisbruik en verspreiding van beelden daarvan tegen te gaan. Het gaat in feite om drie verschillende maatregelen. Allereerst gaat Apple in de VS CSAM-detectie toepassen op de iCloud-fotobibliotheek van gebruikers.

CSAM staat voor Child Sexual Abuse Material.

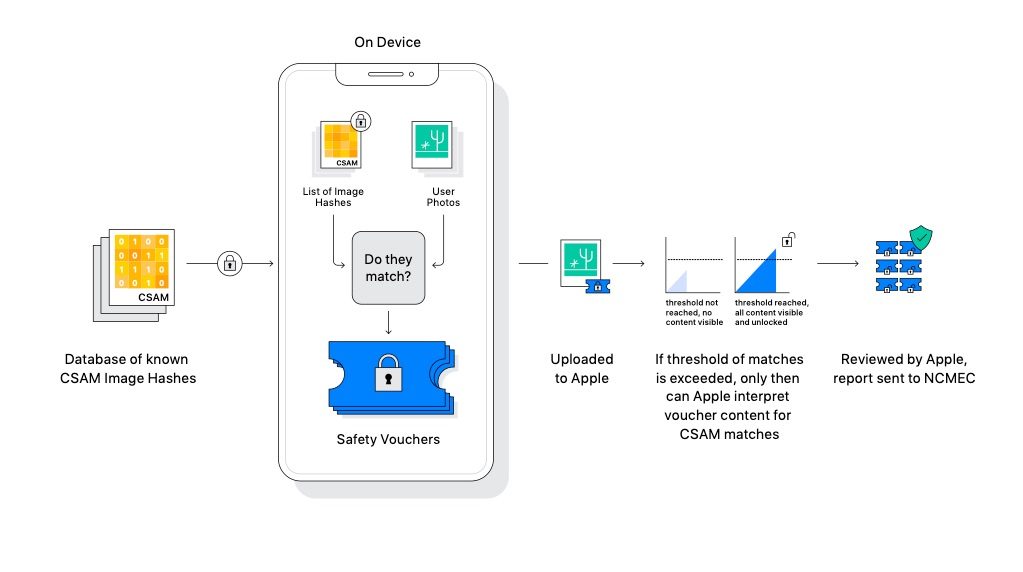

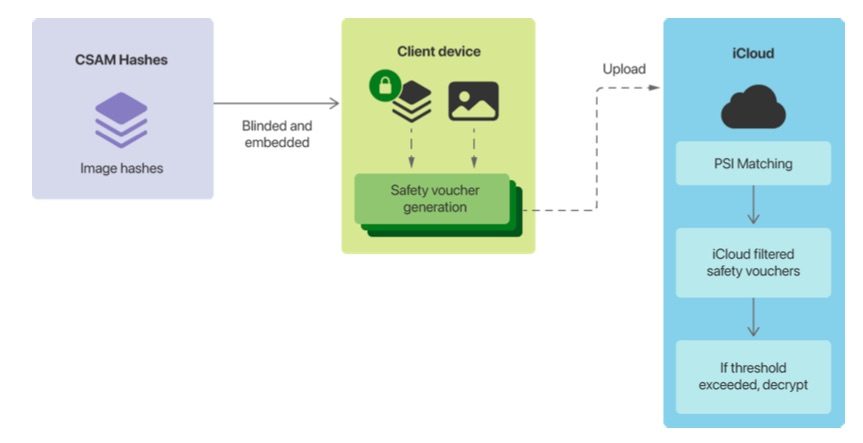

Wat Apple in feite gaat doen, is het vergelijken van foto’s met een database van beeldmateriaal van bewezen kindermisbruik. Apple kijkt daarbij niet wat er op jouw foto’s staat (en scant dus niet op de hoeveelheid bloot op foto’s), maar voert een berekening uit op het beeldmateriaal. De uitkomst daarvan (hash) wordt vergeleken met de uitkomst van bekende kindermisbruikfoto’s, waarop dezelfde berekening is uitgevoerd. Komt de hash overeen, dan kan dit gerapporteerd worden aan de Amerikaanse autoriteiten. Ook Google werkt met deze hash-gebaseerde methode.

Andere maatregelen zijn meer veiligheid in iMessage, waarbij kinderen onder de 13 een waarschuwing krijgen als zij mogelijk een aanstootgevende foto krijgen toegestuurd. Dit kan worden uitgeschakeld. De derde maatregel is dat Siri en Spotlight aanvullende informatie geeft om ouders en kinderen te beschermen.

#2 Wat doen andere bedrijven?

Google scant al langer online bestanden op CSAM-content en hetzelfde geldt voor Twitter, Microsoft en Facebook. Het belangrijkste verschil is dat zijn online content scannen, terwijl Apple het belooft lokaal te doen. Sinds 2013 wordt al gebruik gemaakt van PhotoDNA, een door Microsoft ontwikkelde methode met hash-technologie.

#3 Is dit nieuw, of gebeurde het al langer bij Apple?

Het is goed om je te realiseren dat Apple al langer scant op CSAM-content, in ieder geval sinds 2019. In dat jaar paste Apple de privacyvoorwaarden aan om te benadrukken dat geüploade content zou worden gescand op “potentieel illegale inhoud, waaronder materiaal waarop kinderen seksueel worden geëxploiteerd”.

Apple’s hoofd privacy Jane Horvath bevestigde in 2020 nog eens dat Apple screening-technologie gebruikt om afbeeldingen met CSAM te detecteren. In dat geval wordt een account uitgeschakeld.

De maatregelen die zijn worden aangekondigd maken vooral duidelijk dat Apple deze activiteiten verder gaat opschalen en gebruikers meer bewust te maken dat er op CSAM wordt gescand. Volgens sommige experts is de huidige kritiek een storm in een glas water omdat iedereen had kunnen weten dat het al gebeurde.

Shock news, people – Twitter, Microsoft, lots of companies **do this already**. Facebook started in 2011. This is from a story I wrote in **2013**. https://t.co/8dKrm2mhj9 https://t.co/9UtDZCPJaS

— Charles Arthur (@charlesarthur) August 5, 2021

Verder is het zo dat je lokale fotobibliotheek al veel langer wordt gescand, bijvoorbeeld om gezichten, dieren, landschappen en dergelijke op foto’s te herkennen. Dit gebeurt echter lokaal en wordt niet gerapporteerd aan Apple of aan instanties.

#4 Treft dit alle gebruikers?

Allereerst is het goed om te weten dat alle drie maatregelen aanvankelijk ingevoerd worden in de VS. Apple gaat deze maatregelen dus (nog) niet invoeren bij Europese gebruikers. Dat neemt echter niet weg dat Apple dat op den duur wel kan doen. Apple heeft in een verklaring uitgelegd dat het bedrijf verdere uitrol per land zal overwegen, nadat de juridische haalbaarheid is onderzocht. Een tijdlijn werd niet gegeven.

De maatregelen zijn ook niet meteen van kracht, maar zijn onderdeel van iOS 15, iPadOS 15 en macOS Monterey. Deze updates verschijnen in het najaar van 2021.

Voor de CSAM-detectie geldt dat het alleen gebeurt als je gebruikmaakt van iCloud-foto’s. Bewaar je de foto’s alleen offline op je toestel, dus zonder synchronisatie met de cloud, dan zal Apple de detectie niet toepassen.

#5 Gaat Apple al mijn foto’s scannen?

De CSAM-detectie werkt lokaal op je toestel zelf. Apple bekijkt of de hash van een foto overeenkomt met de hash van een bekende CSAM-afbeelding. Het matchen van hashes gebeurt allemaal op het toestel zelf, dus niet in de cloud. Apple stuurt dan ook geen foto’s op naar een server.

De iPhone analyseert dus niet de inhoud van foto’s die op je toestel staan en kijkt niet of er blote lichaamsdelen, huidkleurige vlakken of gezichten van minderjarigen op staan, maar onderwerpt alle foto’s aan een berekening, waarvan de uitkomst wordt vergeleken. De term ‘scannen’ is daarom wat misleidend. Hoe het technisch werkt lees je in deze uitleg. Ook vind je hier een goede uitleg hoe Apple’s systeem van Private Set Intersection werkt.

Bij het analyseren van foto’s die kinderen via iMessage delen wordt overigens wel de inhoud gescand op mogelijk bloot. Dit staat los van het detecteren van CSAM-content en kan worden uitgeschakeld.

#6 Waarom is dit potentieel gevaarlijk?

De meerderheid van de gebruikers zal maatregelen tegen kinderporno alleen maar toejuichen. Maar onder het mom ‘kinderbescherming’ wordt een systeem ingevoerd, dat ook op andere manieren misbruikt kan worden. Als Apple op CSAM-content kan scannen, zet dit de deur open voor het detecteren van allerlei andere content.

Werkt het systeem goed, dan is het een kleine stap om ook andere foto’s te detecteren en te vergelijken met een database van foto’s van bekende politieke activisten, foto’s van protestbijeenkomsten, actieposters en dergelijke. Gebruikers vertrouwen erop dat Apple ethische keuzes maakt en hier niet aan meewerkt, maar zou kunnen buigen onder druk van ‘foute’ regimes. Organisaties zoals EFF zijn dan ook tegenstander en spreken van een “achterdeurtje naar je privéleven”.

#7 Ziet Apple al mijn foto’s in de bibliotheek?

Omdat het matchen met de CSAM-database alleen op het toestel zelf gebeurt, ziet Apple niet welke foto’s jij in je bibliotheek hebt staan. Apple gebruikt bovendien een cryptografische technologie. Deze bepaalt of er inderdaad sprake is van een match, maar kijkt niet wat er op de foto’s te zien is. Ook Apple kan de foto niet zien, zelfs niet als er een match gevonden is. Bij één match zal het systeem niet meteen alarm slaan.

Pas na een bepaald aantal matches met CSAM-content zal Apple in actie komen en de resultaten delen met autoriteiten, als er inderdaad sprake is van een groot aantal positieve matches.

#8 Zijn de foto’s van mijn kinderen veilig?

Ja. Er zijn veel gebruikers die nu bang zijn dat onschuldige foto’s van hun kinderen nu door Apple bekeken worden of aangemerkt worden als kinderporno. Omdat het systeem hashes van bewezen kindermisbruikfoto’s vergelijkt, is de kans klein dat een onschuldige foto van jouw kind in bad precies overeen komt met bekende kinderporno. Dit kan alleen gebeuren als je de foto zelf hebt gepubliceerd op Facebook en dergelijke, waarna de foto in kringen van kindermisbruik verder is verspreid. Foto’s waar je zorgvuldig mee omgaat zullen niet in de database van bewezen CSAM-foto’s.

Apple zegt dat er bij één op een biljoen positieve matches per jaar, sprake blijkt te zijn van een fout positief resultaat. Hoewel Apple er alles aan zal doen om dit te voorkomen, kan het in theorie natuurlijk wel gebeuren dat een foto onterecht in de database terecht komt.

#9 Is dit systeem waterdicht?

Nee. Zoals de foutmarge wel laat zien, is dit systeem niet waterdicht. Er kan om wat voor reden dan ook een foute positieve match naar voren komen, wat verregaande gevolgen kan hebben voor een onterecht beschuldigde gebruiker. Een deel van de kritiek is hier ook op gebaseerd. Apple zegt de privacy van gebruikers te waarborgen, maar tegelijkertijd is het de realiteit dat Apple onterecht foto’s uit jouw bibliotheek als CSAM kan aanmerken.

#10 Kan ik dit uitzetten?

Zoals aan het begin al gezegd, gaat Apple dit in eerste instantie alleen invoeren in de VS. Apple heeft bevestigd dat de CSAM-detectie niet toegepast wordt als iCloud-foto’s is uitgeschakeld. Wil je dus niet dat hashes van foto’s op je device gematcht worden met hashes van een bewezen CSAM-database, dan moet je iCloud-fotobibliotheek uitschakelen.

Voor wat betreft het analyseren van afbeeldingen die gedeeld worden via iMessage, geldt dat dit werkt via opt-in. Ouders kunnen dit voor hun kinderen inschakelen, om kinderen te waarschuwen voor mogelijk gevoelige beelden. Wil je als ouder niet dat foto’s in iMessage geanalyseerd worden, dan kun je het uitgeschakeld laten.

#11 Apple staat toch voor privacy? Dat lijkt hiermee geschonden!

Er is vanuit de hoek van experts veel kritiek op de maatregelen die Apple hier genomen heeft. Experts van de Center for Democracy & Technology waarschuwen voor de gevolgen van een dergelijk systeem. Het verzwakt volgens hen de privacy van gebruikers. iMessage is standaard end-to-end versleuteld, maar dit wordt afgezwakt als Apple verstuurde foto’s op inhoud analyseert.

#12 Apple zegt toch nooit achterdeurtjes in te bouwen?

De nieuwe maatregelen lijken inderdaad in contrast te staan met eerdere uitspraken van Apple. Apple zegt nooit achterdeurtjes in te willen bouwen in de beveiliging van iOS en de iPhone en iPad, omdat dit misbruikt kan worden. Apple zei in het verleden geen achterdeurtjes voor China te hebben ingebouwd. In een eerdere zaak zei Apple letterlijk het volgende:

Apple heeft nooit een achterdeur van enige soort ingebouwd in iOS, of op een andere wijze de data die is opgeslagen op de iPhone of in iCloud technisch beter toegankelijk gemaakt voor welke buitenlandse regering dan ook.

Met de nieuwe maatregelen lijkt daar juist wel sprake van te zijn, zo zeggen ook privacy-experts. “Het mechanisme dat Apple in staat stelt om berichten in iMessage te scannen is geen alternatief voor een achterdeur. Het ís een achterdeur”, aldus experts.

#13 Wat zijn de gevolgen voor de toekomst?

Apple gebruikt dit systeem nu voor het herkennen van mogelijke foto’s met kindermisbruik. Maar dit zou zomaar de eerste stap kunnen zijn. Overheden willen al jaren dat bedrijven als Apple mogelijkheden inbouwen om bijvoorbeeld versleutelde berichten te kunnen onderscheppen. Apple heeft zich hier jarenlang tegen verzet (de beruchte achterdeurtjes), maar lijkt nu toch enigszins in te stemmen (al is het voor een nobel doel, namelijk het tegengaan van verspreiding van kinderporno). Maar Apple’s argument was altijd dat een eenmaal ingebouwde achterdeur verregaande gevolgen kan hebben. Als je iemand een vinger geeft, kan hij zomaar je hele hand grijpen.

No matter how well-intentioned, @Apple is rolling out mass surveillance to the entire world with this. Make no mistake: if they can scan for kiddie porn today, they can scan for anything tomorrow.

They turned a trillion dollars of devices into iNarcs—*without asking.* https://t.co/wIMWijIjJk

— Edward Snowden (@Snowden) August 6, 2021

Overheden kunnen (in theorie) steeds meer gaan vragen van Apple en andere techbedrijven. Dat is dan ook de angst die nu leeft bij critici en beveiligingsexperts. Het zou een deur openen naar een vorm van surveillance, zeker in landen waar overheden strenge controle uitoefenen op burgers. Hoe dit zich de komende tijd ontwikkelt, moet de toekomst uitwijzen.

#14 Welke acties zijn er al gestart tegen Apple?

Critici hebben Apple in een open brief gevraagd om het plan te staken. De brief is ondertekend door privacy-experts, wetenschappers, onderzoekers, burgerrechtenbewegingen en consumenten. Volgens de auteurs bouwt Apple op deze manier een achterdeurtje in en brengt het de privacy van klanten in gevaar. Apple zou kunnen toegeven aan druk van bepaalde regimes om de functie ook in te zetten voor andere doeleinden. Zo heeft Apple de functie FaceTime uitgeschakeld in Saudi-Arabië, de Verenigde Arabische Emiraten en Pakistan onder druk van lokale wetgeving. Ook stellen de auteurs dat beelden op heel verschillende manieren geïnterpreteerd kunnen worden. “Voor de ene persoon zijn sommige beelden kindermisbruik, voor iemand anders kan dat niet zo zijn.” Zo wordt in de Verenigde Staten paniekerig gereageerd op beelden van een blote tepel, terwijl dat in andere landen niet meteen als porno wordt gezien.

Ook hebben andere bedrijven zich gemeld. WhatsApp-baas Will Cathcart stuurde een reeks tweets de wereld in waarin hij de plannen van Apple veroordeelt. Hij vindt het een stap in de verkeerde richting en vindt dat het de privacy van mensen wereldwijd bedreigt. WhatsApp’s moederbedrijf Facebook neemt het echter ook niet zo nauw met privacy.

#15 Hoe reageert Apple op alle ophef?

Apple lijkt nog niet van gedachte te zijn veranderd na alle ophef. Apple heeft wel een eigen FAQ gepubliceerd, waarin enkele belangrijke vragen beantwoord worden. Echt nieuwe informatie levert dit niet op. Apple zegt dat techniek voor de CSAM-detectie uitsluitend hiervoor gebruikt zal worden. Ook zegt Apple dat verzoeken van overheden om andere beelden dan CSAM-foto’s aan de database toe te voegen, geweigerd zullen worden. Tegelijkertijd zijn de antwoorden soms wat misleidend. Apple zegt dat niet alle foto’s gescand worden, omdat het alleen toegepast wordt op foto’s die gebruikers naar iCloud geupload hebben. Maar in de realiteit betekent dit toch dat alle foto’s vergeleken worden met hashes uit de database, omdat in het geval van iCloud-fotobibliotheek de complete fotobibliotheek geüpload is. Er is geen mogelijkheid om per foto te kiezen welke je wel of niet in iCloud wil zetten (en dus om aan te geven welke wel of niet gescand en vergeleken mogen worden).

Je vindt de FAQ over CSAM van Apple en de communicatiebeveiliging in iMessage op deze pagina.

- 2021 - 03 september: De functie is een paar maanden uitgesteld.

- 2021 - 09 augustus: Link naar eigen FAQ van Apple toegevoegd.

Taalfout gezien of andere suggestie hoe we dit artikel kunnen verbeteren? Laat het ons weten!

Het laatste nieuws over Apple van iCulture

- Hierom gaat Apple vandaag in beroep tegen de boete van €500 miljoen voor overtreden van Digital Markets Act (07-07)

- De Europese verpakking van iPhones en iPads heeft vanaf vandaag iets extra's (20-06)

- Nederlandse kabinet stelt richtlijnen op voor smartphone- en social mediagebruik kinderen: dit staat erin (17-06)

- Xcode 26 krijgt ondersteuning voor AI-modellen: zo wordt ontwikkelen eenvoudiger (11-06)

- Jony Ive slaat handen ineen met OpenAI: komt er een nieuwe iPhone-concurrent aan? (22-05)

De iPhone en iPad voor kinderen

De iPad en iPhone zijn ook leuk voor kinderen. Met deze artikelen zorg je dat kinderen ze veilig kunnen gebruiken, met onder andere informatie over delen met gezin, ouderlijk toezicht, tijdslot instellen en leuke apps vinden. En met Schermtijd beperk je de tijd die kinderen (of jijzelf) kunnen doorbrengen op de iPhone en iPad. Ook lees je hoe je een Apple ID voor kinderen kunt aanmaken.

- Ouderlijk toezicht gebruiken

- Schermtijd op iPhone en iPad

- Applimieten instellen in Schermtijd

- Begeleide toegang gebruiken

- iPad-gebruik van kinderen beperken

- Geschikte apps voor oudere iPad zoeken

- Leerzame programmeerapps voor kinderen

- Tijdslot voor kinderen instellen op iPhone en iPad

- Thuisknop blokkeren op de iPad

- iPad-apps filteren op leeftijd

- iPad kindveilig maken met beschermhoezen

- Apps voor kinderen tijdens lange autoritten

- Meldingen uitschakelen op een gezamenlijke iPad

- In-app aankopen uitschakelen

- Alles over Delen met gezin

- Apple ID voor kinderen

Geld dit ook voor fotos die je via je reservekopie opslaat

Of echt alleen iCloud foto’s?

Hoewel het misbruik van kinderen verachtelijk is, lijkt me dit een verkeerde maatregel. Het is een kwestie van tijd(-sgeest) dat ook andere zaken zullen worden ‘gescand’. Het unique selling point van Apple is hiermee verleden tijd. Ik zou willen dat Apple zich ook zo druk zou maken om het misbruik van kinderen in de Chinese fabrieken waar iPhones in elkaar worden geschroefd.

Ondanks het feit dat het in dit geval wordt ingezet voor een goede zaak, zal de samenleving langzaam veranderen in een soort big brother is watching you. Als je kijkt hoever men hierin al gaat in China belooft dit niet veel goeds.

Lang verhaal kort. Wil je dit niet, dan iCloud foto’s uitschakelen en geen iMessage gebruiken.

Jouw reactie is te kort door de bocht. Alle andere tech-bedrijven doen het al. Dus als je een foto upload naar Facebook, een mail verzend via Hotmail of Gmail gebeurt dit scannen ook al.

Ik vind het wel zorgelijk dat een eerste stap wordt gemaakt naar het openzetten van iOS al is het doel begrijpelijk en nobel.

@HB: Je stapt er nogal makkelijk overheen. Als je zo redeneert kun je over een poosje je hele iPhone uitschakelen.

Laten we met z’n allen iCloud boycotten, dan zal verplicht zijn om het aan aan te passen/terug draaien of/en privacy te verbeteren!!

Dit betreft niet alleen de cloud. Apple bouwt tevens functies in om op je iPhone te kunnen scannen. De internationale tech sites lopen momenteel storm. Dit is echt een nieuwe dimensie. De technologie er achter kan ook versleutelde Whatsapp/Signal/Telegram berichten gaan omvatten omdat dit op het toestel plaatsvindt. Nu nog bepaalde foto’s, met een druk op de knop is aanpassing mogelijk.

Het is een illusie te denken dat er nog iets niet gemonitord kan worden of al wordt gedaan. Natuurlijk is het recht op privacy het allergrootste.

Maar ik denk dat als je slachtoffer ben, en er worden foute foto’s van je (of je kind) gedeeld en bewaard. Dan heb je vast een ander gevoel bij het harde geroep om privacy. Het idee dat er iets wordt gedaan tegen hufters die foute foto’s hebben/delen/en maken maakt mij blij. En als het dan met respect van privacy kan helemaal geweldig.

Er is veel commotie over dit plan van Apple dat via haar marketing iedereen doet geloven dat het met privacy wel goed zit bij hun producten…

Toch wel ernstige zaken in mijn feed vandaag gelezen…

– Minister Grapperhaus wil overleg met critici over afzwakken encryptie WhatsApp (onder het mom van terreur en criminaliteit).

– Actueel… Apple die justitie taak wilt vervullen door prive klantbestanden te scannen… ??

Best zorgwekkende ontwikkeling in mijn ogen.

Kindermisbruik is zeer ernstig maar dit is niet taak van Apple maar eerder daarvoor bestemde diensten.

Ik boycot dan sowieso iCloud zodra Apple mijn bestanden mag scannen. Off-topic; Gaan we straks ook drones onze huizen laten doorzoeken omdat een algoritme X-persoon als potentieel gevaar bestempeld?

Apple controleert enkel of je kinderporno (i.e. CSAM-foto’s die reeds ontdekt zijn) hebt gedownload zonder alle andere foto’s te analyseren. Een match is puur het resultaat van een rekensom, zonder beeldanalyse.

Het systeem dat Apple zal hanteren is bovendien niet moeilijk te bedriegen. Immers, het spreekt voor zich dat de ‘gevoeligheidsgraad’ van dit soort algoritmes voor diverse beeldbewerkingen van de originele foto uiteraard steeds met het aantal “valse positieven” samenhangt. Volgens Apple is slechts “één op een biljoen positieve matches” effectief valse positief. Dit betekent dat er tijdens deze detectie maar heel weinig marge voor eventuele afwijkingen van het originele beeld toegestaan wordt, ofwel dat je enkel foto’s met een zeer hoge overeenkomst met het origineel aangeduid worden.

Who cares? Ik heb er alleszins geen enkel probleem mee om mijn iCloud-foto’s op dat soort uitermate sterk overeenkomende gelijkenis met kinderporno te laten screenen.

Of dit kan leiden tot toekomstig misbruik? Je kan als gebruiker in elk geval niet meer doen dan te hopen dat Apple in dergelijke gevallen de juiste keuze maakt. Misschien zal een bepaalde overheid op basis van hiervan inderdaad sterke druk op Apple zetten om deze technologie anders in te zetten. Volgens mij is dit echter niet de oorzaak, maar hooguit de aanleiding – deze machthebbers zouden immers in dergelijke gevallen vroeg of laat sowieso dergelijke eisen geuit hebben.

Ik vind persoonlijk dat enkel maar deze vrees voor eventuele, misschien zelfs onvermijdelijke (je kan de technologie namelijk niet zomaar laten verdwijnen) misbruiken in de toekomst ons niet ervan mag weerhouden om met deze technieken vandaag problemen te proberen oplossen. We moeten ervoor zorgen dat onze (zeker noodzakelijke) digitale privacy anderzijds niet tot een totale straffeloosheid van misdrijven leidt

@Pieter: Je mist de essentie van het hele verhaal. Apple scant op jouw toestel naar (nu nog) foto’s. Op basis van een niet hash, want dan is 1 bit verschil genoeg het systeem te omzeilen. Apple scant materiaal op jouw toestel (vergelijkbaar met jouw woning even te doorzoeken om vast te stellen of je iets hebt uitgevreten zonder indicatie dat je verdachte bent). Deze “zoek op jouw telefoon-functie”is een gigantisch gat qua beveiliging op je telefoon en kan al dan niet onder druk van regimes of goede hackers erg makkelijk worden gebruikt voor andere zaken dan foto’s scannen. Apple heeft op jouw telefoon gewoon niks te zoeken, het is vrij aanmatigend om op alle Macs/iPhones zonder dat hier een rechter aan te pas komt data te doorzoeken, te labelen en up te loaden. Want exact dat is wat Apple nu invoert. Microsoft en Google scannen hun cloud, Apple jouw toestel….

Dit is toch te gek voor woorden! Een particulier bedrijf dat voor politie en rechter gaat spelen door dagelijks huiszoekingen doet op je telefoon om te kijken of je niets verdachts hebt gedaan.

(Red.) Link naar eigen FAQ van Apple toegevoegd.

Dit is een heel lastig onderwerp, en dat zie je al aan de uiteenlopende reacties. Het recht loopt hier m.i. iets in achter, de ontwikkelingen op IT gaan zo snel dat het moeilijk is om dit voor het rechtssysteem bij te benen. Bijv. Iedereen heeft tegenwoordig een hoge kwaliteit digitale camera, met een computer en snelle internet verbinding op zak. Hierin is een vacuüm ontstaan tussen wat de IT aan mogelijkheden en de spelregels. Ik vind het alleen niet juist dat een commercieel bedrijf dan in dit vacuüm gaat acteren zonder expliciet verzoek van de overheid. Al hebben ze wel een morele plicht aangezien zij degene zijn die de innovaties voort stuwen. Vergelijk het met de autogordel, toen Ford hiermee kwam in 1956, was het om de gebruikers van de auto te beschermen. Tegenwoordig is het een verplichting dat die in iedere auto zit en dat je die draagt. De wet ijlt altijd iets na, alleen tegenwoordig op het gebied van IT iets meer. De geneugten van de snelle veranderingen binnen de IT omarmen we met heel veel liefde, de beperkingen helaas niet waardoor het nog meer vertraagt wordt.

De mensen die nu hoog en laag springen dat het schande is dat Apple dit doet, Apple is relatief laat met deze oplossing, andere tech giganten doen het al jaren. Ze zien daarvoor niet je foto’s, ze kijken naar de hash en vergelijken dit met een lijst aan hashes (meervoud van hash?) die samengesteld is door met name de NCMEC.

Persoonlijk vind ik de oplossing ook niet toereikend. Het richt zich namelijk op bestaand materiaal. Zodra het riskanter is bestaand materiaal te hebben tegenover nieuw materiaal te maken…. nou ja dan snap je het wel. Dus wat mij betreft zouden de logaritmes aangescherpt kunnen worden om ook nieuw beeldmateriaal te herkennen.

Hoe dan ook is het dweilen met de kraan open. Het internet brengt de meest uiteenlopende mensen steeds makkelijker bij elkaar. Hiermee worden gevoelens versterkt en makkelijker met elkaar gedeeld als zijnde ‘normaal’. Daarnaast heb je een segment van ‘gebruikers’ die continu opzoek zijn naar een seksuele kick. Hoe groter de taboe, hoe groter de kick. Die seksuele kick is steeds moeilijker te vinden omdat alles ‘normaal’ is, als je het kunt bedenken is er vast wel een website die erop in is gespeeld. Deze groepering zal mogelijk nooit de theorie in praktijk brengen, alleen vergeten gemakshalve dat het pornografische materiaal wel gemaakt moet worden. Waar weer een verdienmodel achter zit.

De roep voor privacy en de roep van veiligheid staan continu lijnrecht tegenover elkaar. Wat ook goed is, want daarmee hou je alles scherp. Alleen de ontwikkelingen op het gebied van IT en wereldwijd de toegankelijkheid hiervan, maakt dit een hele moeilijke en daardoor vertragende discussie.

Ik heb enige tijd gewerkt voor de Raad voor de Kinderbescherming, waardoor ik dit mogelijk vanuit een gekleurd perspectief schrijf.

Kan zijn dat ik er compleet overheen lees. Maar een hee belangrijk ding vind ik de vraag “wat gebeurt er als er iets gedetecteerd wordt”.

Oké in het artikel staat dat personen <13 jaar een melding krijgen als ze een mogelijke foute foto toegestuurd krijgen.

Maar wat als “het algoritme “ een mogelijk foute foto bij jou vind.

Microsoft en Google zijn al bekend om het blindelings afsluiten van accounts als er iets MOGELIJK verdachts gevonden wordt. Zonder recht op verdediging, uitleg, weerwoord of kans op herstellen van het account. Ook bij account waas mensen vee geld in hebben zitten (xbox aankopen bijvoorbeeld).

Dus krijg je alleen maar een waarschuwing dat er iets gevonden is met de mogelijkheid of het verzoek dit te verwijderen of iets dergelijks of gaat Apple ook de kant op dat accounts geblokkeerd worden zonder mogelijkheid op een weerwoord.

Dat lijkt me toch een zeer belangrijke vraag waarvan ik nog steeds geen antwoord lees.

Precies wat hier boven geschreven wordt. En vinden ze een mooie vakantiefoto die toevallig voldoet aan deze criteria (vals positief, lees de Microsoft en Google topics) dan ben je toegang tot al je data en aankopen kwijt. Ik had net 500gb foto’s geëmigreerd naar icloud, gaat er komende weken weer allemaal uit…

@Pieter: Mooi verwoord, vooral die laatste alinea.

De situatie die je nu schetst is haast niet mogelijk. De kans dat jou vakantiefoto’s gaan voldoen aan die normen zijn zeer onwaarschijnlijk, of je moet op je vakantie foto’s maken die extreem veel lijken op bestaande pornografische afbeeldingen van kinderen.

Natuurlijk zullen er in het begin fouten zijn gemaakt door Google en MS, dat sluit ik niet uit. En het is heel kwalijk als er onschuldige mensen ergens van zijn beticht of toegang zijn kwijtgeraakt tot een medium. Alleen Apple kennende, komen ze vaak pas op de markt met een oplossing als een andere partij de kinderziektes eruit heeft gehaald. (Tile bijv.)

In het artikel wordt aangegeven dat Apple een melding zal doen bij een justitiële instantie. Deze instantie zal dan vervolg onderzoek doen of er daadwerkelijk sprake is van een misdrijf. Een account zou mogelijk, afhankelijk van de aard van het misdrijf, in de tussentijd geseponeerd kunnen worden gedurende het onderzoek op verzoek van de justitiële instantie.

De vraag die in mijn achterhoofd knaagt is:

Als die mensen ten onrechte zijn afgesloten, hebben ze daarna weer toegang gekregen en hebben ze dit vervolgens gedeeld op hetzelfde forum? Of bleek het achteraf terecht te zijn en hebben ze dat vervolgens gedeeld op hetzelfde forum? Of zijn het allemaal slachtoffers die ten onrechte zijn afgesloten en vervolgens nooit meer toegang hebben gekregen?

Ander onderwerp:

In het artikel worden de Amerikaanse autoriteiten genoemd, ik vraag me af of dat mag met Nederlandse data of dat het naar de Nederlandse autoriteiten gestuurd wordt? Kan ook zijn dat er bij het schrijven van het artikel hier niet bij stil is gestaan en dat het per definitie naar de autoriteiten gaat waar de gebruiker woonachtig is.

Ik ben van mening dat dit een noodzakelijk kwaad is. Helaas zijn er teveel slechte mensen op de wereld die het nodig vinden om onschuldige kinderen te misbruiken.

Ik als vader offer graag een beetje privacy op om kinderen te beschermen.

En 12 miljoen mensen delen sowieso al alles met FB en 10 miljoen delen alles met whatsapp/messenger dus lijkt me een beetje delen met dan ook niet zoveel meer uitmaken.

Dit is mijn mening en ga ik verder niet over in discussie.

Goed plan! Geen probleem mee. Het wordt tijd voor strengere maatregelen tegen dit soort beestachtige praktijken. Ik heb niets te verbergen en te vrezen. Besef dat alles wat je deelt of opslaat per definitie al over de schutting is gegooid. Apple is daar tenminste transparant over.

Zorgelijke reactie van Apple. Deze komt echter niet onverwacht. Apple is helaas vaak van mening dat zij de regels maken en dan is het slikken of stikken. Met deze stap gaan ze echter (gelukkig niet alleen volgens mij) een grote stap te ver. Het verdacht maken van alle gebruikers, het implementeren van Spyware op de devices. Het scannen en versturen van materiaal vanaf devices. Als ik hier dan lees dat men bereid is graag “een beetje” privacy in te leveren kan het alleen maar betekenen dat de impact van deze stap niet duidelijk is. Het doel van dit gebeuren wordt niet bereikt, en alle devices vanaf iOS 15 incl content scanner voor de encryptie met upload… zorgelijk, ik zat te wachten op de nieuwe Mac Book, maar zo koop ik hem zeker niet.

Lees de tekst in het artikel en verdiep je eens in BlockChain dan zal je je realiseren dat Apple privacy nog steeds hoog in het vaandel heeft. Apple vergelijkt de hash van jouw digitale bestand met de hash in een database.

De vraag of het een taak is van een onderneming is een goede maar ik zou me pas echt zorgen gaan maken als Apple dit proces zou over laten aan autoriteiten.

Compleet oneens. Apple implementeert een scan-systeem op apparatuur van klanten. Op basis van een (deels) near hash. Dit heeft niks met een block chain te maken – maar dan ook compleet niks. Het is gewoon een gigantische stap een scan systeem OP een gekocht toestel te implementeren. Een systeem dat bovendien bestanden die het “verdenkt” upload en ter beoordeling aanbiedt. Dit systeem kan vandaag de rotzooi zoeken waarvoor het zogenaamd is gemaakt, morgen dissidenten, overmorgen interessante documenten van bedrijven. Daarnaast kan het nog eens worden gehackt. In plaats dat Apple eens reageert op de kritiek nav Pegasus, het feit dat heel veel erkende security engineers melden dat Apple grote stukken software opnieuw moet programmeren omdat de fabel “onze software is veilig” zwaar is achterhaald… implementeren ze een spy functie op alle toestellen die ze aanbieden. Doorzoeken is voorbehouden aan andere instanties na beoordeling van een rechter – niet aan Apple. Dit is iets wat zelfs Facebook, Microsoft en consorten niet in het hoofd halen. Zij scannen in clouds, maar niet op end devices met alle risico’s van dien. Gelukkig lopen niet de minste organisaties storm tegen dit plan. Het zal Apple typisch niks helpen, maar mensen worden wel bewust van keuzes. Extra betalen voor een stuk privacy? Dat is geen argument meer. Apple zal op andere wijze met de technisch op veel gebied geavanceerdere, gunstigere concurrentie moeten dealen. Ik ben heel benieuwd.

“Ik heb niets te verbergen” impliceert dat je weet wat je te verbergen hebt en voor wie. En ‘wie’ is natuurlijk niet alleen

Inderdaad. Iedereen heeft direct een mening klaar voordat men zich ook maar even verdiept hoe het werkt.

Hoe nobel het doel ook is, ik vind het niet terecht om onacceptabele methoden te gaan gebruiken om dat doel te bereiken. Dit gaat ten kosten van alle gebruikers en ook ik denk: wat volgt er later wellicht nog meer. Nee Apple, ook in mijn ogen gaan jullie hiermee te ver en ook al beloven jullie de privacy overeind te houden, begin ik hier nu een gezond wantrouwen tegen te koesteren. Per slot beloven alle techbedrijven dat onze privacy in goede handen is. Ondertussen weten wij wel beter. Hou je bij je leest Apple, gewoon goeie producten maken en stoppen met het uithangen van de moraalridder of voor politieagentje gaan spelen. Als dit daadwerkelijk in Nederland gaat worden ingevoerd dan stop ik met het gebruik van alle Apple apparatuur. En nee, ik heb ook niks te verbergen maar ik weiger toe te staan dat techbedrijven voor mij gaan bepalen wat er goed of fout is. Dan maar een Nokia 3310.

@hans: Apple bepaalt ook niet “wat er goed of fout is” dat doet de wetgever.

(Red.) De functie is een paar maanden uitgesteld.