Een week na de aankondiging dat Apple kinderen beter wil beschermen en kindermisbruik wil opsporen, overheerst nog altijd de kritiek van privacyexperts én gebruikers. De kritiek gaat voornamelijk over de functie waarbij Apple hashes van foto’s van gebruikers vergelijkt met hashes van bewezen kindermisbruikfoto’s. Reuters schrijft nu dat eigen Apple-medewerkers er ook niet op gerust zijn dat het bij deze functie blijft. Ze zijn bang dat de privacy van gebruikers in het geding komt.

‘Kritiek Apple-medewerkers op scannen iCloud-foto’s’

Bronnen bij Apple zeggen tegenover Reuters dat er een intern Slack-kanaal is waar meer dan 800 berichten gedeeld zijn. Daarin wordt voornamelijk kritiek geuit op Apple’s plannen. Het is niet voor het eerst dat er intern kritiek is over bepaalde beslissingen, maar de bronnen merken op dat de discussie nu een stuk heviger is en langer duurt dan bij eerdere privacygevallen. De kritiek komt voornamelijk van medewerkers buiten het privacy en securityteam.

Veel Apple-medewerkers zijn er bang voor dat het systeem in de toekomst misbruikt kan worden door bepaalde overheden om ook andere zaken op te sporen dan alleen kindermisbruikfoto’s. Denk dan aan foto’s waarin kritiek geuit wordt op de overheid. Dit heeft als gevolg een strenge vorm van censuur. Hoewel Apple dit in een eigen FAQ tegenspreekt en zegt dat het systeem ontworpen is voor louter het tegengaan van de verspreiding van kinderporno, zijn de medewerkers (en ook privacyexperts) hier niet gerust op. Medewerkers zijn ook bang dat Apple zijn reputatie op het gebied van privacy over boord gooit.

In het Slack-kanaal zijn ook medewerkers die het voor Apple opnemen. Andere zeggen dat Slack niet de juiste plek is om het onderwerp te bespreken.

FAQ over scannen foto’s op kindermisbruik

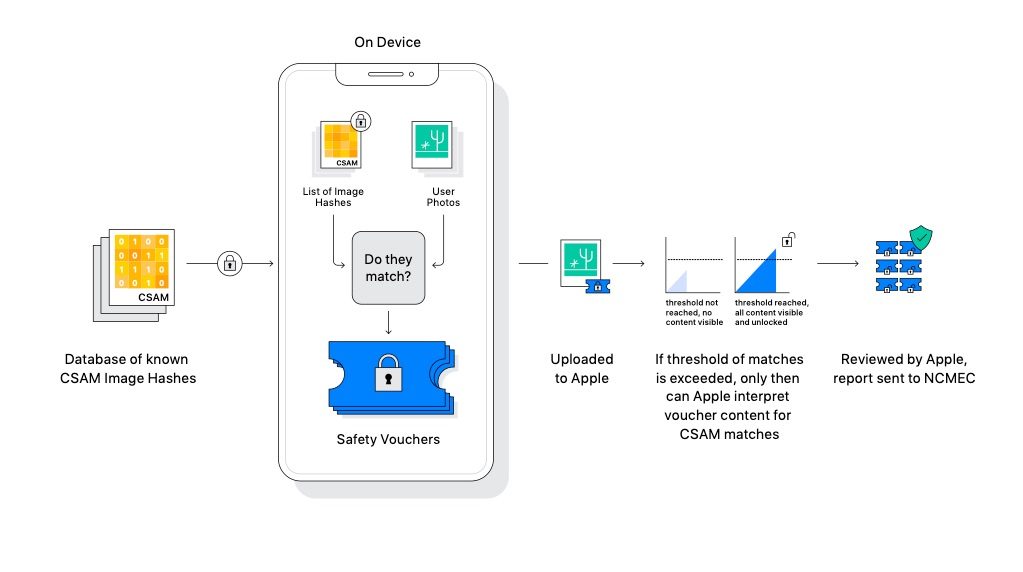

De afgelopen week is er van meerdere kanten kritiek gekomen. Niet alleen privacyexperts en eigen medewerkers, maar ook andere personen van bedrijven als WhatsApp hebben kritiek geuit op de plannen van Apple. Het idee voor het bestrijden van kindermisbruik is goed, maar de vraag is of dit de beste manier is. In onze uitgebreide FAQ over CSAM-detectie en het scannen van iCloud-foto’s lees je hoe het systeem werkt en welke kritiek er is.

Taalfout gezien of andere suggestie hoe we dit artikel kunnen verbeteren? Laat het ons weten!

Het laatste nieuws over Apple van iCulture

- ‘Apple overweegt eigen AI-modellen aan de kant te zetten, wil OpenAI of Anthropic voor slimmere Siri’ (01-07)

- Apple gaat vaker functies later (of helemaal niet) in de EU uitbrengen: dit is waarom (01-07)

- 20 jaar Apple Podcasts: dit zijn de beste shows (volgens Apple) (27-06)

- Inhaalslag voor AI: 'Apple overweegt overname Perplexity AI' (23-06)

- Apple laat je de snelheid voelen met haptische trailer van F1: The Movie (13-06)

De iPhone en iPad voor kinderen

De iPad en iPhone zijn ook leuk voor kinderen. Met deze artikelen zorg je dat kinderen ze veilig kunnen gebruiken, met onder andere informatie over delen met gezin, ouderlijk toezicht, tijdslot instellen en leuke apps vinden. En met Schermtijd beperk je de tijd die kinderen (of jijzelf) kunnen doorbrengen op de iPhone en iPad. Ook lees je hoe je een Apple ID voor kinderen kunt aanmaken.

- Ouderlijk toezicht gebruiken

- Schermtijd op iPhone en iPad

- Applimieten instellen in Schermtijd

- Begeleide toegang gebruiken

- iPad-gebruik van kinderen beperken

- Geschikte apps voor oudere iPad zoeken

- Leerzame programmeerapps voor kinderen

- Tijdslot voor kinderen instellen op iPhone en iPad

- Thuisknop blokkeren op de iPad

- iPad-apps filteren op leeftijd

- iPad kindveilig maken met beschermhoezen

- Apps voor kinderen tijdens lange autoritten

- Meldingen uitschakelen op een gezamenlijke iPad

- In-app aankopen uitschakelen

- Alles over Delen met gezin

- Apple ID voor kinderen

Ik snap beide kampen maar tegelijkertijd is de kritiek ook op angst gebaseerd. Misschien handig om een pilot te draaien?

Het continue doorzoeken van toestellen is al een no go. Dan ook nog eens op basis van een database waarvan niemand de inhoud kent. Er wordt overigens niet op hash waarden gezocht maar op 100% matches en gelijkenden. In hoeverre de “gelijkende” routine gelijkend definieert blijft een geheim van Apple. Het doorzoeken van apparatuur kan binnen een rechtsstaat slechts nadat iemand verdachte is en een rechter dit heeft getoetst. Op een telefoon staat vaak een essentieel gedeelte van iemands leven, ook zaken die niet worden gedeeld via Facebook en co. Apple implementeert nu dus een framework dat encryptie om zeep helpt, het mogelijk maakt ongezien data te “beoordelen” en deze ook up te loaden ter controle. Apple als politieagent. Een commercieel bedrijf met slechts 1 doel: winst gaat op deze stoel zitten en pakt het recht te gaan doorzoeken zonder enig daderindicatie. Los van het feit dat Apples software zeker niet feilloos is (Pegasus als mooi voorbeeld) waardoor misbruik van deze functie zeer reëel is. Daarnaast wil Apple deze functie naar eigen zeggen ook voor derden openen.

Met andere woorden, onder het mom van een goede zaak waar toch niemand tegen kan zijn stapt Apple een gigantische grens over waar zelfs Google zich nog niet aan heeft gewaagd: iedereen is verdachte, we doorzoeken alle apparaten door ons gefabriceerd op basis van data die volledig intransparent is, op ieder moment kan veranderen.

Het is niet voor niets dat Apple door (zelfs de fanboys) hevig onder vuur ligt. Als dit niet wordt geschrapt voor mij geen iPhone 13 en nieuwe Mac Book. Binnen het bedrijfsleven is er dito discussie in hoeverre een big Brother telefoon (ingebouwde scanner) hanteerbaar.

Ik vind het echt onzinnig, continu worden er extreme omstandigheden gebruikt om mensen nog meer te volgen of te analyseren. Iedereen is tegen kinderporno, terrorisme enz. enz. Maar naar mijn inziens zullen door al deze kleine stappen geen privacy meer overblijven. Het wordt ieder keer een stapje erger. Na 10 jaar is het: Doei privacy. Dan blijkt achteraf waarschijnlijk ook nog dat er helemaal niets is veranderd aan het doel van het vermijden van kinderporno of terrorisme…

Ik ben een iPhone gebruiker van het eerste uur en nooit iets anders meer gehad maar als ze dit implementeren dan stap ik over naar Android. Zij hebben niks te zoeken in mijn fotoalbum en wat is de volgende, mijn contacten doorzoeken of ik een enig relatie heb met terroristen?

@Jay: Ja, want Google scant niets 🙄🤣

Dit gaat het bedrijf zeer veel negatieve reclame opleveren en ik ben het persoonlijk ook niet eens met een scan functie op mijn telefoon… geloof best dat het in NL aan banden gelegd kan worden maar voor andere landen met een ander regemie is de privacy voor de mensen weg !!

Apple stop met deze onzin !!

Scannen prima, maar niet achter mijn voordeur !

Nu scannen ze alleen als je foto’s upload naar de cloud,

maar ik garandeer dat de volgende stap is dat Apple het nog makkelijker voor je gaat maken, om bestanden naar de cloud te uploaden, door alvast AL JE BESTANDEN te scannen en de hashes aan te maken, voor jouw gemak.

NEE !

@Jean-Paul Horn | iCulture.nl: Dat klopt, maar we betalen ook hoofdprijs voor Apple’s apparaten, deels omdat ze hun privacy zaken goed op orde hebben. Een deel van de kopers zal hun keus voor Apple hierop gebaseerd hebben en die gaan dan wellicht terugswitchen, omdat het aan andere kant goedkoper is, als het dan toch al overal gescand gaat worden…

Hiermee draaien ze hun privacy-paradepaardje vakkundig de nek om. Hun marketing op dit punt wordt zo een lachertje. Apple doorbreekt hiermee de E2E encryptie. En dit gaat heel wat verder dan Google etc. Het opent de deur voor overheden om te zeggen: Hé, het kan dus echt wel! Zorg dus maar dat je het mogelijk maakt als wij hiervoor een wet maken. Dus het hek is van de dam.

Ik ben geen kenner maar vraag me af of kindermisbruikers sowieso hun ‘misbruikfoto’s’ op hun telefoon of iCloud laten staan. Dat is toch meer de wereld van het Darkweb?

Deze opmerking is vrij kort door de bocht. Google scant niet op deze manier, op het toestel door middel van een speciaal daar voor gemaakte “trojan”. Voor de encryptie op een gekocht toestel.

Iedereen die hier niets van snapt of nu gaat zeggen dat ze het er niet mee eens zijn vanwege privacy redenen… jammer dan haha dan moet je echt geen smartphone meer gebruiken. Ieder tech bedrijf scant en Facebook met Instagram en whatsapp wat meen je wat die allemaal weten over onze berichten foto’s en video’s en dit is echt niet alleen bij Apple zo ieder bedrijf weet veel te veel over ons maar ja heb je wat te verbergen?

@Sebastian: Dus jij staat erachter dat pandora’s box open mag en privacy verleden tijd is?

Voor jou is de box al open, en accepteer je dat ook als een gegeven.

Ik ben er juist voor dat een vuist moet worden gemaakt tegen ieder tech bedrijf dat scant en analyseert met je eigen persoonlijke data.

Dadelijk voel je je gevangen in het digitale web/wereld wat je tot je kist volgt en dat van je nazaat.

Om het even extreem te trekken. Stel we accepteren dit, dan krijg je straks algoritmes die zelf je hele familie een score kan geven van de afgelopen 30 jaar. etc etc.

“Wat heb je te verbergen” als argument aandragen getuigt van enig kortzichtigheid. Ten eerste weet je niet welke partijen op basis van wat welke data van jou interssant vinden (nu en in de toekomst, een database vergeet niks). Ten tweede gedragen mensen zich altijd anders als ze weten dat ze continu worden bekeken (niet meer vrij). Ten derde kan een controle systeem fouten maken, worden gemanipuleerd, daar kun je leuk last mee krijgen. Ten vierde, niks te verbergen? Joh! Zet je huisdeur open en nodig iedereen uit lekker in je hele hebben en houden te neuzen.

En als laatste. Je argument van insta Facebook en co is gewoon kul. Dat zijn berichten die bewust worden gedeeld, geen doorzoekingsalgoritme ingebouwd en actief, standaard ben je verdachte gemaakt.

Denk even na voordat je roept dat je niks te verbergen hebt en dit vergelijkt met Google en Facebook.

Gelukkig leven we hier nog in een democratisch land, met scheiding der machten en bepaalt niet een tech bedrijf wie er verdachte is en wat het gaat doorzoeken… Althans dat dreigt nu te veranderen en als consument hebben we dan gelukkig de keuze het bedrijf vaarwel te zeggen.

Correct me if I’m wrong: Dat is een api voor Google SE, niet voor Android. En als ik mijn pics in de cloud op Google Photos zet dan kies ik er zelf voor net zoals dat ik mijn backup op iCloud zet.

@Sebastian: Dus jij vindt het geen verschil dat wanneer een techbedrijf foto’s scant bij uploaden naar de Cloud of dat een techbedrijf spyware op je duur gekochte toestel plaatst om te scannen op foto’s met de mogelijkheid om daar nog veel andere zaken in mee te nemen. Heeft totaal niks te maken met iets willen verbergen, wel met baas willen zijn over je eigen toestel. Het lijkt er meer op dat je het zelf niet helemaal snapt. Persoonlijk wil ik niet dat een techbedrijf voor mij gaat bepalen wat goed of slecht is. Dat kan ik zelf heel goed inschatten, dat hoeft Apple niet voor mij te doen. Als ze dit doorzetten dan komt er voor mij geen iPhone 13 maar wel een Pixel 6, dan weet ik in ieder geval vooraf hoe het met de privacy zit. Als je als bedrijf de mond vol hebt over privacy dan is dit in ieder geval de mogelijkheid om je geloofwaardigheid in één keer om zeep te helpen.

@TheRealMelvin: Die is er al sinds 2019, want sindsdien is Apple al aan het scannen.

@Jan Willem: Die “deur voor overheden” kan open gaan wanneer die overheden dat willen. Denken dat dat nu pas een mogelijkheid is nu Apple van plan is te scannen voor CSAM is behoorlijk naïef.

Privacy is anno 2021 allang een utopie. Als mensen echt eens zouden weten hoeveel data er nu al op straat ligt! 😅😰😱

Zoveel redenen waarom dit onbegrijpelijk is.

Apple, het bedrijf dat privacy op #1 had staan.

Zou dit een soort verkeerde PR stunt zijn of zo?

Ik kan me ook niet voorstellen dat je dat soort walgelijke dingen op je iPhone/iCloud gaat bewaren.

Stel dat je alle kinderporno in kaart zou kunnen brengen. Hoeveel % zou er dan daadwerkelijk op een iPhone of iCloud staan?

Idd meer iets voor darkweb of usb sticks oid toch?

Gaat mij niet om wel of niet iets te verbergen hebben maar wat gaat de volgende stap zijn? Racistische iMessages checken?

Waarom dit wel en niet meewerken aan het unlocken van telefoons van terroristische of drugsgerelateerde verdachte personen?

Het is wachten op aanklachten van gebruikers die hier onterecht verdacht van worden. Dat kan elke Apple jurist toch zo voorspellen?

Kortom ontzettend vreemde stap van Apple.

Op de eerste plaats zullen wij er niet mee geconfronteerd gaan worden want wat Apple wil voldoet niet aan de AVG/GDPR. Het zal vooral een USA issue worden.

Op de tweede plaats bezitten we wel een iPhone maar hebben we slechts een gebruiksrecht op de software. Juridisch ben je daarvan niet de eigenaar. Ook niet van je iCloud opslag.

Op de derde plaats begrijpt niemand deze ultieme marketing truc. Ze hadden deze kritiek verwacht en zullen deze feature gaan terugtrekken (vandaar geen aankondiging tijdens de WWDC) en dan de wereld vertellen “wij luisteren naar onze klanten die privacy hoog waarderen en maken het makkelijker voor Android gebruikers om over te stappen”……… snappie? Let maar eens op tijdens de iPhone 12S presentatie.

Haha daar gaat het grote Apple is het merk als je gesteld bent op je privacy…😂

Apple is dus niet zo verschillend als al die andere smartphone bedrijven.

Ik ben een enorme Fan en heb alle producten in huis en werkt zoals het moet werken.

Maar hier schrok ik wel even van als ze dit gaan doen ga ik al mijn abonnementen bij Apple opzeggen want ik wil mijn privacy behouden.

Hier gaan ze echt heel veel inkomsten mee mislopen en gaat misschien mijn favo techbedrijf voor korte duur naar de knoppen!

asjeblieft Apple think different en luister naar de consumenten en je eigen medewerkers! Want anders ben ik straks geen Fan meer

Privacy staat voorop!!