Met de iPhone XR belooft Apple een ‘nieuw tijdperk van fotografie’. Het draait steeds minder om camerasensors, lenzen en de expertise van de fotograaf, maar om processors en slimme algoritmes. Kunstmatige intelligentie en snelle chips zorgen ervoor dat de camera precies de juiste instellingen kiest. Daardoor zien je foto’s er mooier uit, zelfs als je beginnersfouten maakt, zoals tegen de zon in fotograferen. Sterker nog: Apple moedigt je zelfs aan om niet te veel na te denken over de lichtomstandigheden bij het maken van een foto, want de camera regelt het allemaal zelf. Maar hoe krijgt Apple het voor elkaar met de enkele camera in de iPhone XR?

iPhone XR heeft beste enkele camera

Er was deze week opmerkelijk nieuws van DxOMark, de camera-experts die uitgebreide tests uitvoeren. Zij vinden de iPhone XR het toestel met de beste enkele camera ooit in een smartphone. Daarmee streeft Apple de eerdere koploper Google Pixel 2 voorbij. Als het om belichting, kleur, detail en ruisonderdrukking gaat doet de iPhone XR niet onder voor de veel duurdere iPhone XS. Alleen bij de portretmodus doet de XR het net iets minder vanwege de enkele camera. De kleuren van de iPhone XR camera zijn levendig en prettig om te zien onder de meeste omstandigheden. De autofocus werkt snel en hoewel de witbalans iets koeler dan normaal is ingesteld, is dat niet iets waar je als gebruiker last van hebt. De testers zijn daarom behoorlijk positief over Apple’s goedkoopste iPhone van 2018.

iPhone XR camera: veel mogelijkheden

Ook bij andere fabrikanten zien we dat een enkele camera helemaal niet zo vreemd is. Zo kiest ook Google bewust voor een enkele camera in de Pixel-telefoons. Dat heeft ermee te maken dat de ontwikkelingen steeds meer richting computational photography gaan. Algoritmes bepalen hoe een foto eruit komt te zien en daarmee bepalen techbedrijven steeds vaker wat mooi is en hoe een goed gelukte foto eruit ziet.

Het mooie is: de iPhone XR camera aan de achterkant biedt ongeveer dezelfde mogelijkheden als de dubbele camera van de iPhone XS. Apple belooft Smart HDR, aanpasbare scherptediepte en een verbeterd bokeh-effect. Je kunt dan ook de wazigheid op de achtergrond handmatig aanpassen. Dat geldt ook voor de selfie-camera, die dankzij de TrueDepth-camera een dieptekaart van je omgeving maakt. De front/selfiecamera van de iPhone XR is trouwens identiek aan die in de iPhone XS, dus daar zullen we in dit artikel niet uitgebreid op in gaan. De camera aan de achterkant is veel interessanter.

Met deze foto wil Apple bewijzen dat je prima tegen de zon in kunt fotograferen.

De camerasensor aan de achterkant heeft zowel bij de iPhone XR als bij de XS grotere en diepere pixels, zodat er meer licht op de sensor komt. Het resultaat is dat je betere foto’s krijgt, ook bij zwakke verlichting. Tenslotte zorgen de snellere sensors voor betere actiefoto’s. Zero shutter lag zorgt ervoor dat de foto wordt gemaakt op het moment dat jij op de sluiterknop drukt en niet een fractie van een seconde erna, zodat je niet dat ene actiemoment mist. Dit zijn allemaal camerafuncties die de iPhone XS ook biedt, maar de XR doet hetzelfde met een enkele camera. Of de kwaliteit ook hetzelfde is? Daar kunnen we pas over oordelen als we de iPhone XR een tijdje hebben gebruikt. In onze iPhone XS Max review hebben we al laten zien wat de kwaliteitsverschillen zijn met eerdere iPhones, waaronder een iPhone 7 met enkele camera. Maar omdat dit toestel alweer een paar jaar oud is en niet de Smart HDR-functies en andere nieuwigheden bevat, is het niet te vergelijken.

Het mooie van de camera’s in álle 2018 iPhones is dat het beeld al volledig wordt geanalyseerd voordat je op de sluiterknop drukt. Bij portretten gebeuren er dan drie dingen:

- Gezichtsherkenning: de Neural Engine gebruikt machine learning om data van de camerasensor te analyseren, om te kijken of er een gezicht in beeld is.

- Facial landmarking: is er een gezicht in beeld, dan zorgt facial landmarking ervoor dat je de effecten van portretbelichting kunt toepassen.

- Depth mapping: de ISP gebruikt data van de Neural Engine om het object te scheiden van de achtergrond. Dit gebeurt in meerdere lagen, zodat je achteraf nog de scherptediepte kunt aanpassen.

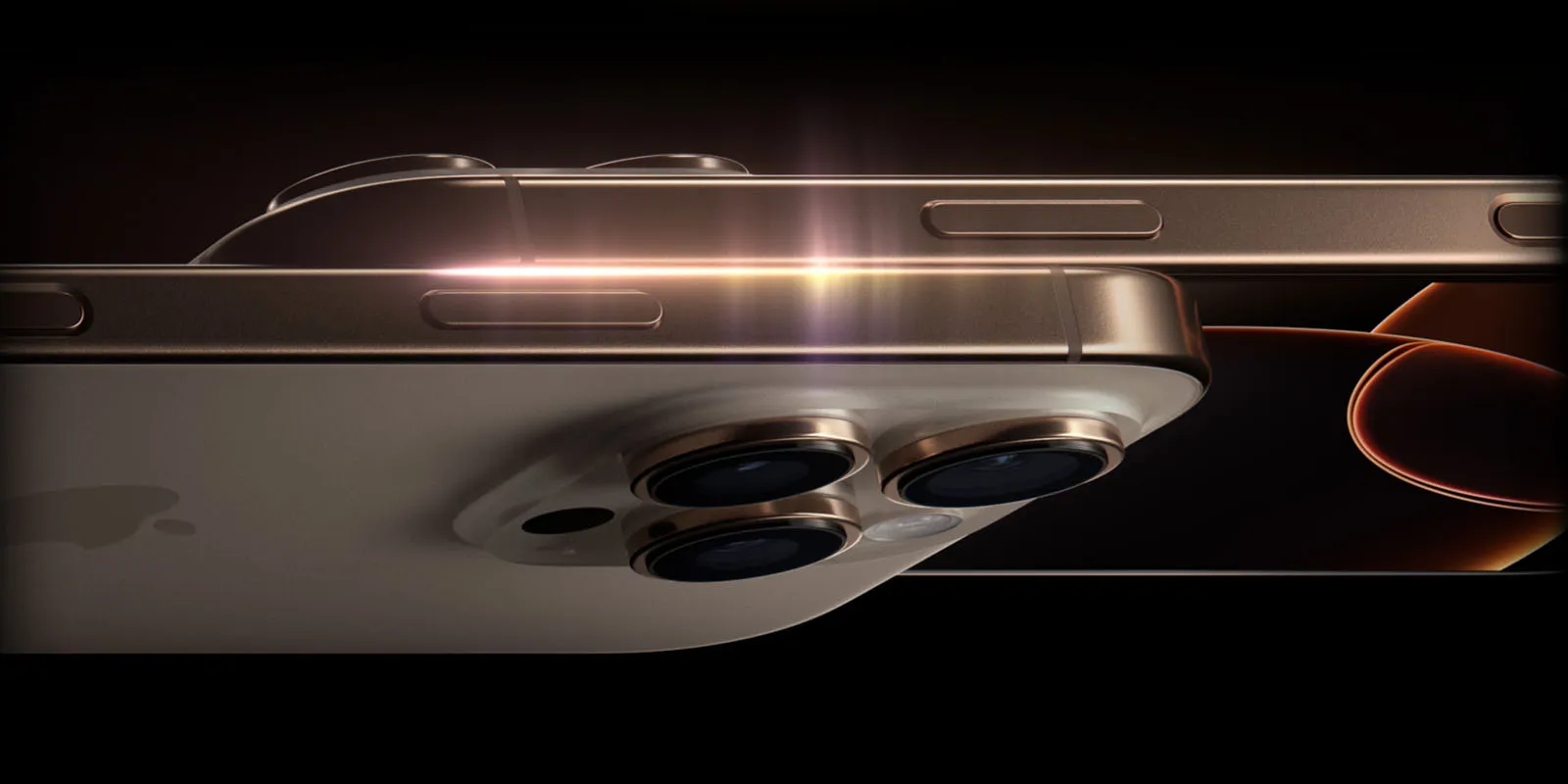

En dat is nog maar een fractie van wat het camerasysteem allemaal doet. Dit werkt allemaal met een enkele 12 megapixel camera met groothoeklens met een diafragma van ƒ/1.8. De sensor daarvan is 2x sneller dan die van de iPhone X. Met behulp van OIS, optical image stabilization, wordt gezorgd dat het beeld mooi stilstaat. De Neural Engine en de ISP (Image Signal Processor) vormen het brein dat ervoor zorgt dat je foto’s er beter uit zien.

Wil je videofilmen, dan kan dat in 4K, met een verbeterde dynamisch bereik bij video’s tot 30fps. Ook neemt de iPhone XR het geluid in stereo op en bij het afspelen heb je een breder stereo-afspeelbereik, waarbij het geluid beter wordt gescheiden. Dat zit overigens ook allemaal op de iPhone XS, wat nog maar eens benadrukt dat je met de iPhone XR echt heel veel functies krijgt die je ook op de duurdere topmodellen vindt.

Waarom heeft de Google Pixel 3 een enkele camera?

Tot zover de technische specs, maar hoe slaagt Apple erin om dit met slechts één camera te doen, terwijl ze beloven dat je ongeveer dezelfde mogelijkheden hebt als met de dubbele camera van de iPhone XS? Apple heeft zelf het geheim nog niet verklapt, maar misschien helpt het om eens bij Google te gaan kijken. De Pixel 2 kreeg lovende kritieken vanwege de uitstekende (enkele) camera. Bij de Pixel 3 heeft Google opnieuw gekozen voor een enkele camera. Google’s standpunt is: “Alles wat met AI mogelijk is, doen wij beter”. Terwijl andere fabrikanten twee cameralenzen voor nodig hebben, zegt Google dezelfde kwaliteit te kunnen bieden met een enkele cameralens. Tot nu toe zijn ze daar behoorlijk goed in geslaagd.

Google begint zo’n twee jaar voordat een nieuwe smartphone op de markt komt al met de ontwikkeling van de camerafuncties, nog voordat er aan de smartphone zelf wordt gewerkt. Het camerateam zette voor de derde generatie Pixel 10 mogelijke functies op een rij, waar Google’s onderzoeksteam voor computational photography aan moest gaan werken. Fotograferen bij slechte lichtomstandigheden is één van de aandachtsgebieden waar zowel Google als Apple apart onderzoek naar doen. Die lijst werd ingekort tot een stuk of vier, die zowel technisch mogelijk waren en ook nog nuttig voor gebruikers: Top Shot, Photobooth, Super Res Zoom en Motion Auto Focus. Alle vier gebruiken ze AI en machine learning om objecten te herkennen of om klunzig gedrag van gebruikers te compenseren (zoals het eerder genoemde onbewust tegen de zon in fotograferen). Sommige functies worden mogelijk door betere hardware, zoals een nieuwere sensor, maar de laatste jaren ligt de nadruk vooral op meer intelligentie.

Ook bij de Pixel 3 heeft Google opnieuw gekozen voor een enkele cameralens, terwijl concurrenten zoals Samsung al overwegen om VIER cameralenzen te gebruiken. Volgens vice president product management Mario Queiroz is het niet nodig om twee lenzen te hebben, vanwege Google’s expertise in machine learning. Pixel-smartphones krijgen genoeg diepteinformatie vanuit de dual-pixel-sensor van de camera en met algoritmes kun je dan toch het gewenste foto-effect krijgen. Google heeft de algoritmes getest op miljoenen foto’s, waar ze gratis over kunnen beschikken dankzij de fotodienst Google Foto’s.

https://www.youtube.com/watch?v=vKSA_idPZkc

Toch is niet alles met software haalbaar. Google gebruikt bijvoorbeeld Visual Core, een speciale co-processor die in samenwerking met Intel is ontwikkeld. Dit is een speciale AI-chip die bijvoorbeeld zorgt voor HDR+, een tegenhanger van Apple’s Smart HDR. Apple heeft die taken verdeeld over twee hardware-componenten, de ISP en de Neural Engine. Die laatste voert volgens Apple 5 biljoen bewerkingen per seconde uit.

Google gebruikt de Visual Core onder andere voor de functie Top Shot. Daarbij wordt een serie foto’s gemaakt waarbij automatisch de best mogelijke wordt geselecteerd. Oftewel: de foto waarop de minste beweging te zien is en waarbij iedereen lacht en geopende ogen heeft. Voor foto’s in het donker heeft Google de Night Sight-functie (dit komt volgend jaar pas beschikbaar). Door meerdere foto’s met langere belichting te maken zitten er altijd wel elementen bij die goed zijn, mits je je hand stil houdt.

Overigens gaat Google met de Pixel 3 nog een stap verder dan Apple, door nog een extra functie van light field photography te introduceren. In plaats van alleen de achtergrond meer of minder blur te geven kun je bij de Pixel 3 ook de focus verplaatsen van het ene object naar het andere. Dit is iets waar Lytro bekend mee is geworden. Apple heeft de kennis en patenten al in huis: ze kregen in juni 2017 al een patent op de technologie van lichtveldcamera’s, oftewel plenoptische camera’s, maar hebben het nog niet toegepast in de iPhone. Wellicht gaan we in de iPhone 2019 als opvolger van de iPhone XS zien dat je ook de focus van een foto kunt verleggen.

Dat Google voor één camera kiest heeft misschien ook te maken met kosten. Hoewel… aan de voorkant heeft de Pixel 3 wél een dubbele camera. Dat zou nodig zijn om breedbeeldselfies te kunnen maken zonder dat je een selfiestick nodig hebt.

Wil je ook een iPhone XR?

Zie je het helemaal zitten met de iPhone XR? Dan kun je onze prijsvergelijker kijken waar je de beste deals kunt vinden.

- 2018 - 11 december: Bijgewerkt met testresultaten van DxOMark.

- 2018 - 15 oktober: Omschrijving zero shutter lag uitgebreid en aangepast.

Taalfout gezien of andere suggestie hoe we dit artikel kunnen verbeteren? Laat het ons weten!

Het laatste nieuws over Apple van iCulture

- Tweede beta van watchOS 11.6 voor ontwikkelaars nu beschikbaar (30-06)

- Van Vision Pro tot slimme bril: dit zijn Apple’s 7 toekomstige headsets (30-06)

- Deze drie nieuwe functies krijgt je HomePod (mini) in het najaar met software-update 26 (26-06)

- 'OLED-display nieuwe M5 iPad Pro is in productie gegaan, op tijd voor release in het najaar' (26-06)

- 'AirTag 2 gespot in broncode iOS 18.6' (en dit is wanneer we hem kunnen verwachten) (25-06)

iPhone XR

De iPhone XR (spreek uit als: iPhone 10R) is Apple's kleurige betaalbare iPhone met 6,1 LCD-scherm uit 2018. In dit overzicht lees je alles over de iPhone XR en of het nog de moeite waard is om dit toestel te kopen. Lees ook onze iPhone XR review met ervaringen.

Zero shutter lag zorgt ervoor dat een actieshot stil lijkt te staan

Uh nee

Zero shutter lag betekend dat de foto meteen gemaakt wordt als je de ontspan knop indrukt.

Er is dus geen vertraging (lag) tussen het afdrukken en de daadwerkelijke foto.

Dat betekend zero shutter lag

Of wel wiki:

A shutter lag is basically the time difference between when the shutter button is clicked in your camera and when the picture is recorded

Goede ontwikkeling. Ik vind het zelf eigenlijk geen porem 3 of 4 lenzen op mijn foon

Toch blijft de lens als nog 1 van de belangrijkste dingen

ben heel benieuwd naar de XR. speciaal gewacht met aankoop van de XS omdat ik wss voor de XR ga. wacht het testen van iCulture nog even af.

“Beginnersfouten zoals tegen de zon in fotograferen”… dit zegt meer iets over diegene die dit stuk geschreven als over de fotograaf.

Professionele fotografen schieten juist veel tegen de zon in voor het beste resultaat. Dit is zelfs mogelijk met iPhones (mits je in RAW schiet). Maar over het algemeen is het dynamisch bereik van smartphonecamera’s niet bepaald spectaculair. Met andere woorden: het is geen beginnersfout om tegen de zon in te fotograferen, maar een beperking van de smartphonecamera’s dat die daar niet mee overweg kunnen.

(Red.) Bijgewerkt met testresultaten van DxOMark.