Overdreven effecten door Smart HDR

In theorie is Smart HDR op de iPhone een prima oplossing: foto’s worden automatisch net iets mooier gemaakt door informatie van meerdere lenzen en meerdere opnames te combineren. Bij de camera in de iPhone 14 Pro wordt zelfs de informatie van een 48-megapixelcamera gebruikt om er een zo mooi mogelijke 12-megapixelfoto van te maken. Maar al die nabewerking heeft ook een nadeel: de foto kan er nogal fake uit gaan zien. Dat beweert youtuber Marques Brownlee, beter bekend als MKBHD. En hij is niet de enige.

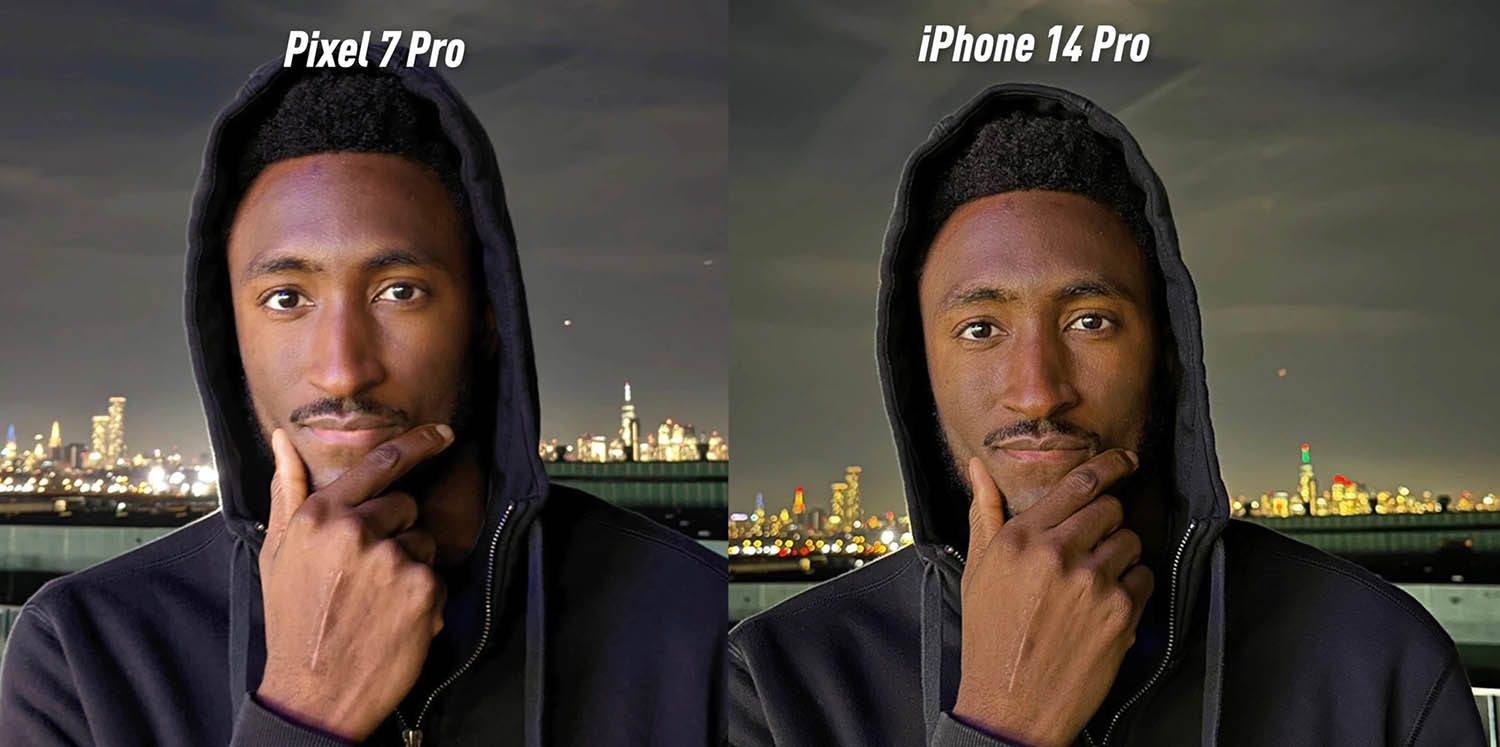

MKBHD voerde eind vorig jaar een blinde test om te kijken welke smartphone de beste foto’s maakt. De Google Pixel 6A won daarbij de eerste prijs en de Pixel 7 Pro kwam als tweede uit de bus. Apple scoorde lager. Het viel al eerder op dat de nabewerking van de iPhone-camera overdreven resultaten kan geven en nu heeft MKBHD in een nieuwe video uitgelegd waarom de foto’s die je met de iPhone 14 Pro maakt er soms zo onnatuurlijk uit zien.

Voorheen stond Samsung erom bekend dat ze onnatuurlijke foto’s maken, passend bij de Aziatische voorkeur voor flatteuze foto’s en extreme verzadiging. Apple ruïneert de foto’s ook, maar doet dat op een heel andere manier. Donkere gedeeltes worden extra opgelicht in een poging om meer detail te laten zien. Bij iemand met een donkere huidskleur kan dat een overdreven effect geven, waardoor iemand er juist lelijker uit ziet op een foto. Apple probeert de schaduwen op te lichten, vooral op het gezicht, met als gevolg dat het er kunstmatig uit ziet. De huidtint klopt ook niet meer met wat hij zelf als natuurlijk ervaart.

Bij gunstige omstandigheden zoals een heldere lucht of een persoon die bij daglicht wordt belicht en een duidelijke achtergrond heeft, ziet het er normaal uit. Maar als er verschillende kleuren en texturen te zien zijn, gaat de slimme HDR-functie er niet zo slim mee om. Apple voegt elk jaar nieuwe software-functies toe om de foto’s die je maakt met nog meer stappen na te bewerken. Maar dat maakt de foto’s niet beter. Sebastiaan de With, de man achter de populaire camera-app Halide, heeft eerder ook al gewezen op de tekortkomingen van Smart HDR. Bij tegenlicht probeert de iPhone de mensen op de foto op te lichten, waardoor ze er onnatuurlijk en gebleekt uit zien.

This effect is part of Apple's Smart HDR, which 'segments' human subjects in photos and boosts their brightness significantly when backlit post-capture.

We've illustrated the subject detection and a likely 'how it looked' to the camera:

(This does not occur when capturing RAW) https://t.co/5APCtqKu7t pic.twitter.com/nKjaYQgVnc

— Halide + Kino aka halideapp.bsky.social (@halidecamera) September 20, 2022

Dit kun je er nu al aan doen

Smart HDR snijdt de menselijke figuren uit de foto en licht ze vervolgens op. Apple zou dit kunnen oplossen door een schakelaar toe te voegen, zodat je Smart HDR kunt uitschakelen. Een andere optie is om een RAW-foto te maken met een app zoals Halide, maar dan krijg je een veel te groot fotobestand en moet je zelf nog aan de slag gaan met nabewerking. Dat komt er vaak niet van. Gebruik je Apple’s eigen ProRaw-foto’s, dan is het goed om te weten dat die achteraf ook nog worden nabewerkt. De meest simpele oplossing is om een Live Photo te maken, maar ook dat heeft weer nadelen. Die bewegende foto’s nemen meer ruimte in op je iPhone. Nee, een schakelaar voor Smart HDR, dát zou pas handig zijn. Misschien in iOS 17?

Taalfout gezien of andere suggestie hoe we dit artikel kunnen verbeteren? Laat het ons weten!

Het laatste nieuws over Apple van iCulture

- Wat wordt er écht nieuw? Dit zijn de 8 verwachte nieuwe functies in de iPhone 17 Pro (Max) (17-07)

- Nieuwste geruchten over de opvouwbare iPhone: release, schermformaat, prijs en meer (17-07)

- 'iPhone 17 Pro-scherm krijgt betere coating': dit verandert er (17-07)

- Komt er een nieuwe kleur voor de iPhone 17? 'Dit zijn álle kleuren van de iPhone 17-serie' (16-07)

- iPhone 17 Air: de titaan van de nieuwe iPhones? (16-07)

Ik heb dit ook gemerkt laatst op vakantie bij een foto van ons bij een zonsondergang. Door Apple’s nabewerking leek net of we voor een greenscreen stonden. Ik heb gemerkt dat wanneer je bij een live-foto een andere hoofdfoto kiest de nabewerking niet wordt toegepast.

Simpelste oplossing: gebruik een andere camera-app. De onnatuurlijke look van veel foto’s die ik met de standaard camera-app op mijn 13 Pro maakte heeft mij allang naar Camera Pro ‘verjaagd’. Veel uitgebreidere en fijnere app ook nog eens, ook voor video. Nog een groot voordeel: als ik in Camera Pro de 3x zoom kies, dan wordt ook echt altijd de lange lens gebruikt! De standaard-app kiest dan vaak voor digitaal zoomen met de groothoek, en dat ziet er niet uit…

Je kunt toch ook RAW kiezen als je zelf wilt nabewerken?

@Patrick: Thanks voor de tip. Ik zocht net even maar welke app bedoel je precies? En als Halide er last van heeft als aparte app, waarom heeft camera pro er dan geen last van, enig idee ?

Ik probeerde net een selfie te maken, foto’s lijken wel of het met mn vriend zijn Samsung is gemaakt. Baal hier ontzettend van… Had dit niet met mijn 12 pro

Op mijn iPhone 11pro heb ik wel de optie om smart HDR aan of af te zetten, is die optie dan niet beschikbaar op de iPhone 14pro ?

Het is allemaal nep wat de klok slaat, bij de ene aanbieder wat meer dan bij de ander. Vroeger waren het de Apple klonen die dit deden, om met slechtere hardware nog mee te kunnen komen, nu doet Apple het zelf ook, omdat ze aan het eind van hun innovatie vermogen zijn gekomen.

Bewonderingswaardig is volgens MKBHD dat de Pixel een sensor gebruikt die al 4 jaar oud is en nog steeds uitmuntend is. Kun je nagaan wat software kan doen!

Ik maak om die reden ook steeds minder vaak foto’s met m’n iPhone en heb ik een professionele systeemcamera aangeschaft. Momenteel een fotografie cursus aan het doen om het apparaat te leren kennen. Het resultaat is wel veel gaver!

Beetje overtrokken conclusies allemaal.

@Patrick: Bedoel je Procam of Procamera of …?

Volgens mij staat er niet dat Halide er ook last van heeft, maar dat je Halide kunt gebruiken om een RAW zonder nabewerking te maken. En ik bedoelde ProCamera.

Op de iPhone 11 Pro kun je Smart HDR helemaal uitzetten, via instellingen > Camera

@Patrick: thanks!!

Dit is de reden waarom ik Halide gebruik. Je kan Halide ook gebruiken om een jpg of heic foto te maken in plats van Raw. Dit zorgt meestal voor een vee beter resultaat dan de “stock” camera.

Ook bij de iPhone 12 Pro (Max)kun je die HDR functie uitzetten. Daarbij moet gezegd worden dat RAW niet standaard ingeschakeld is, en je altijd JPEG/HEIF schiet. RAW is ook bedoeld om foto’s achteraf bijgewerkt dient te worden omdat het bruto informatie bevat. Een professionele fotograaf (die z’n brood er mee verdiend) weet meer uit een iPhone Pro te halen en ook betere resultaten kan neerzetten dan een amateur. Als je een amateur professionele tools geeft draait het op stront uit, en dat komt dat degene gebrek heeft aan ervaring en kennis. Als je een professional consumenten tools geeft kan hij er een heel eind mee komen, maar zal nooit het gewenste eindresultaat behalen omdat de tools beperkt zijn ten opzichte van de prof.

Zowel tools als degene die het bedient moet evenredig zijn. Dan kom je tot de beste resultaten terecht. En volstaat hetgeen ook wat je voor ogen hebt., tot het gewenste eindresultaat!

Er zijn zat mensen die een iPhone 14 Pro hebben, maar gebrek aan kennis en ervaring hebben. daardoor geen 10% van zijn kunnen komen en benutten, wat resulteert tot niets.