Apple kondigde eind 2021 twee plannen aan om kinderen te beschermen. De ene is al in productie gegaan en waarschuwt als een minderjarige een foto met veel naakt wil delen. De andere maatregel leidde tot een stuk meer ophef op: Apple wilde kinderporno opsporen door de foto’s te analyseren die je naar iCloud uploadt. Privacyexperts trokken aan de noodrem: Apple zou er helemaal mee moeten stoppen. En ook organisaties voor kinderbescherming waren erop tegen. Apple schrok van de reacties en stelde het uit.

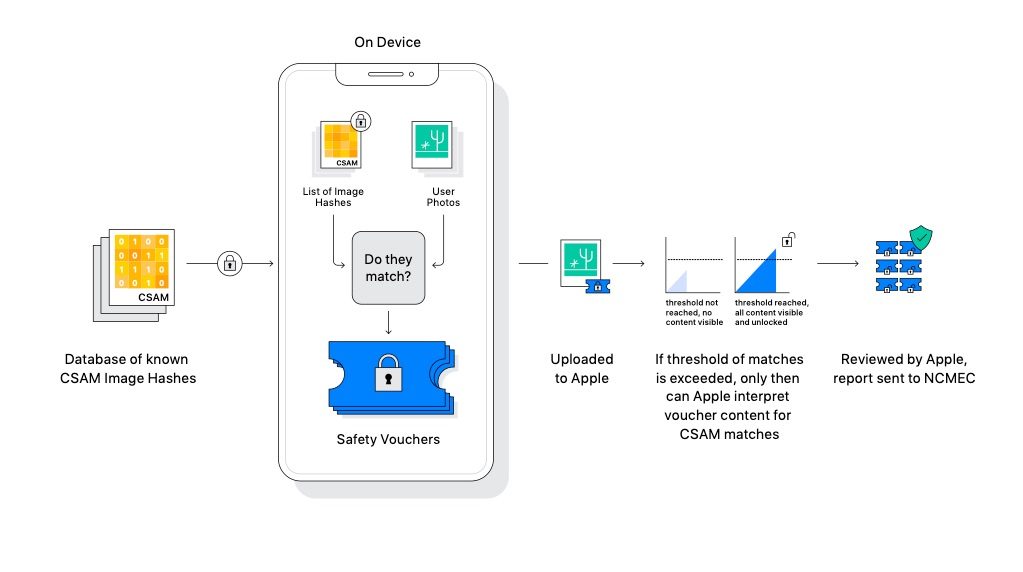

Technisch gezien leek Apple de ‘perfecte’ oplossing te hebben gevonden. De foto’s zouden niet daadwerkelijk worden bekeken, maar er zou alleen een hash worden berekend, die werd vergeleken met de hashes van bekende foto’s van kindermisbruik. Apple heeft nu in een interview met The Wall Street Journal aangegeven dat ze er helemaal mee stoppen. Het interview gaat vooral over de nieuwe plannen rond Advanced Data Protection en maakt duidelijk dat Apple nu een andere insteek heeft gekozen.

Ook is er een officiële verklaring vrijgegeven:

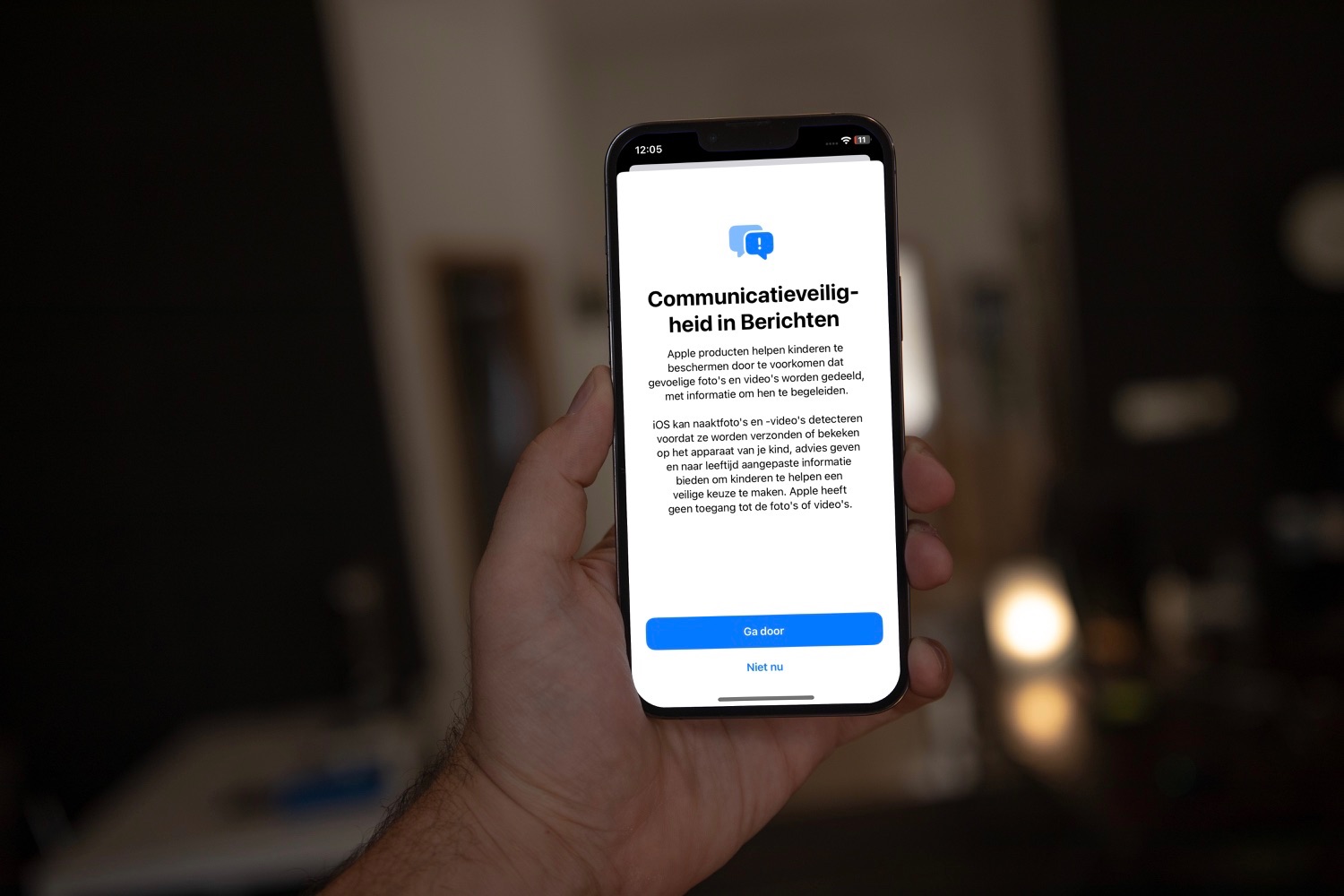

Na uitgebreid overleg met deskundigen over initiatieven voor kinderbescherming die we vorig jaar hebben voorgesteld, gaan we meer investeren in de functie Communication Safety, die we voor het eerst in december 2021 beschikbaar stelden.

Verder hebben we besloten niet verder te gaan met onze eerder voorgestelde CSAM-detectietool voor iCloud Foto’s. Het is mogelijk om kinderen te beschermen zonder dat bedrijven persoonlijke gegevens doorspitten. We zullen blijven samenwerken met overheden, kinderorganisaties en andere bedrijven om jongeren te helpen beschermen, hun recht op privacy te respecteren en het internet een veiligere plek te maken voor kinderen en voor ons allemaal.

Apple heeft nu nieuwe functies aangekondigd, die ervoor zorgen dat iCloud-gegevens nog beter beveiligd zijn. Er komt end-to-end encryptie beschikbaar voor iMessage-berichten, foto’s en meer. Deze encryptie maakt het doorzoeken van foto’s op de server onmogelijk, waardoor Apple’s CSAM-plannen geen zin meer hebben. Tenminste, wanneer je het inschakelt, want de verbeterde encryptie is opt-in. Andere bedrijven zoals Google, Microsoft en Amazon, doen wel aan het scannen van content op de server. Apple denkt echter dat het probleem bij de bron aangepakt kan worden door voorlichting te geven en te voorkomen dat de content überhaupt wordt gemaakt en gedeeld.

Apple’s oplossing: preventie

Op het toestel wordt bijvoorbeeld gedetecteerd of je naar CSAM-content zoekt in Siri, Safari of Spotlight. Je wordt dan doorverwezen naar diensten die je kunnen helpen bij een seksuele afwijking. Ook zal de aandacht bij Apple meer op Communication Safety worden gericht, de functie waarbij kinderen gewaarschuwd worden bij het delen van foto’s met naakt. Lokale algoritmes waarschuwen het kind vóór het verzenden van dergelijke content, zonder dat de ouders een melding krijgen. Apple wil dit uitbreiden naar herkennen van naakt in video’s. Op een later moment kan de functie ook worden uitgebreid naar andere apps en naar apps van derden.

Eerder in het nieuws:

- Gerucht: ‘Apple ontwikkelt tool om kindermisbruik te herkennen in foto’s van gebruikers’

- ‘Apple-medewerkers uiten kritiek op scannen van foto’s bij opsporen kindermisbruik’

- FAQ: Apple’s functies tegen kindermisbruik; privacygevaar of noodzakelijk kwaad?

- Apple stelt CSAM misbruikdetectie een paar maanden uit

- EFF vindt dat Apple helemaal moet stoppen met CSAM

- EU wil dat techbedrijven scannen naar kindermisbruik

De iPhone en iPad voor kinderen