Apple: ‘Ons AI-model presteert beter dan GPT-4’

In een onlangs gepubliceerd onderzoeksartikel beschrijven de AI-experts van Apple een systeem waarin Siri veel meer vaardigheden krijgt. De onderzoekers er zelf van overtuigd dat het beter scoort dan GPT-4, waar tools zoals ChatGPT gebruik van maken. In het artikel beschrijft Apple een spraakassistent die met behulp van een Large Language Model (LLM) veel meer nuttige taken kan uitvoeren. Het model heet afbeelding staat. Ze noemen het ReALM, oftewel Reference Resolution As Language Modeling. ReALM houdt rekening met wat er op je scherm staat, maar kijkt ook naar welke taken actief zijn en welke entiteiten relevant zijn voor een gesprek.

Veel context nodig

Zo wordt er bijvoorbeeld gekeken naar entiteiten die relevant zijn voor een gesprek. Wanneer gebruikers op een normale manier praten, gebruiken ze soms vage taalinvoer zoals: “Kun je dit even voor me pakken?” Een menselijke toehoorder kan op basis van de situatie (een hand die zich uitstrekt, of de kijkrichting van de spreker) begrijpen wat er wordt bedoeld. Een computer heeft er meer moeite mee.

Apple heeft mogelijk een oplossing gevonden, door een model te ontwikkelen dat rekening houdt met allerlei entiteiten die niet expliciet worden benoemd. Dit kunnen achtergrondtaken zijn, gegevens op een scherm en andere zaken. Is een gebruiker aan het koken, dan weet een huisgenoot dat er waarschijnlijk kookspullen of een ingrediënt moet worden gepakt. Staat er iPad met het recept voor een cocktail op het scherm, dan zal er iets van een cocktailshaker of een fles drank nodig zijn. En klinkt er een alarm op de achtergrond, dan is er wellicht meer behoefte aan een brandblusser of blusdeken. Traditionele methodes hebben hiervoor veel grotere modellen en veel meer referentiemateriaal nodig, maar Apple zegt nu de aanpak te hebben gestroomlijnd door relevante factoren te herkennen en om te zetten naar tekst.

Slimmere Siri: gaat het nu echt gebeuren?

Op die manier kan Apple een slimmere en nuttiger Siri bouwen. De snelheid waarmee deze assistent taken kan uitvoeren is veel hoger dan de concurrentie, zeggen de onderzoekers. Als vergelijkingsmateriaal gebruikten ze de ChatGPT-varianten die gebruik maken van GPT-3.5 en GPT-4, de huidige standaarden. Aangezien de ontwikkelingen op het gebied van AI snel gaan, is het goed om te weten dat de vergelijkende test op 24 januari 2024 werd uitgevoerd. Ondertussen kunnen beide modellen alweer slimmer zijn geworden.

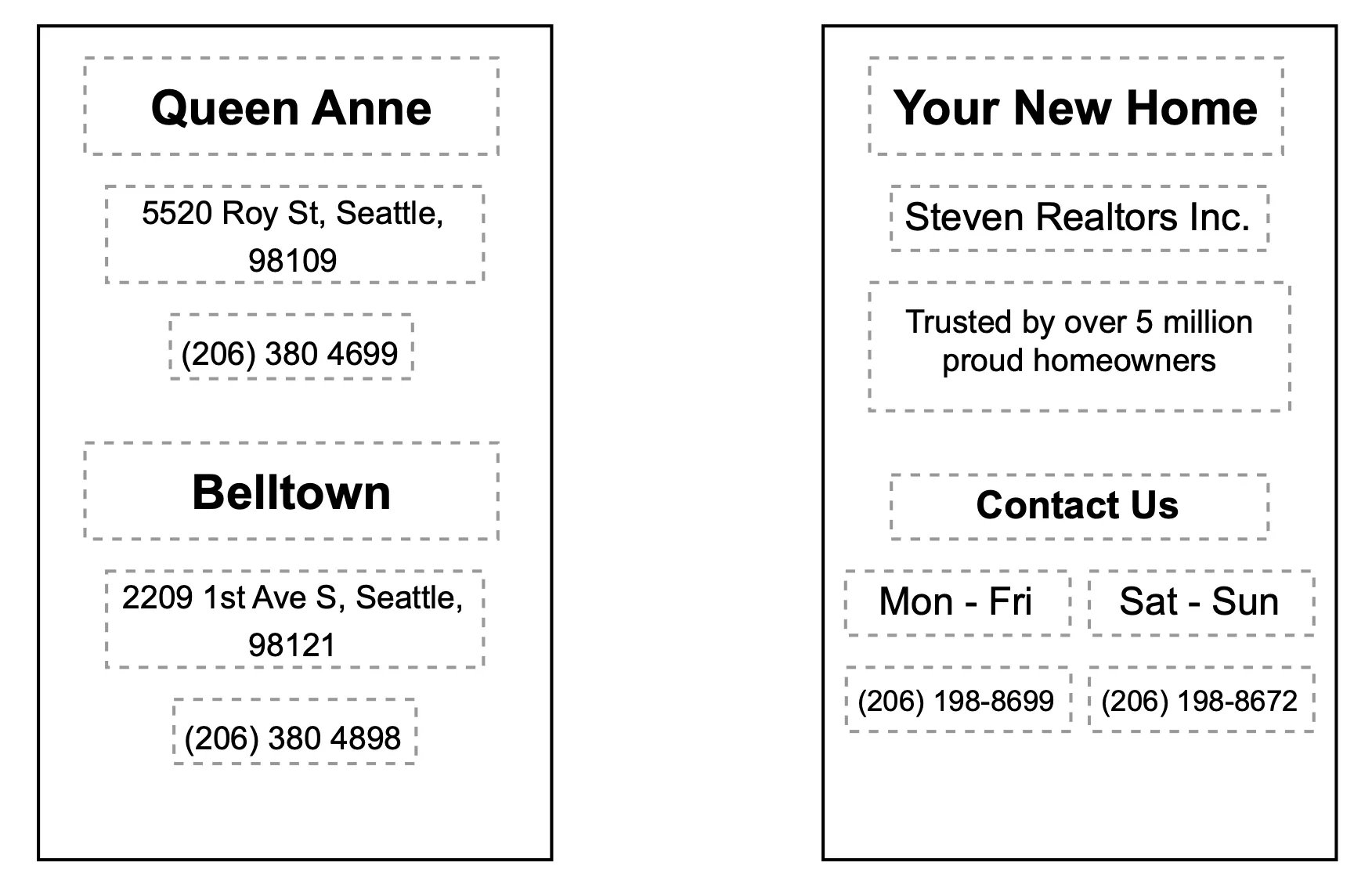

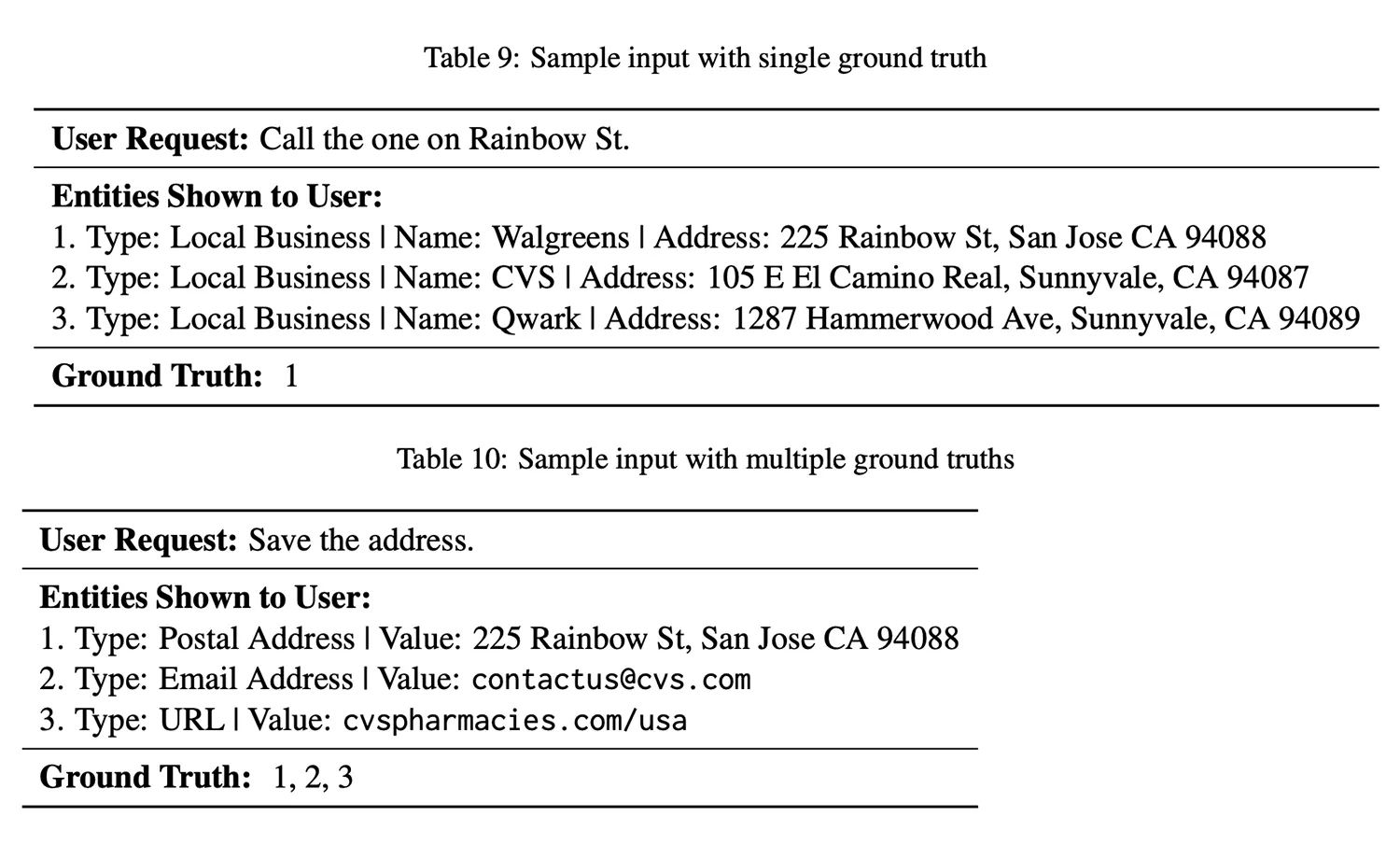

Beide varianten moesten een lijst van entiteiten voorspellen uit een set die vooraf beschikbaar was gesteld. Bij GPT-3.5 werd alleen gebruik gemaakt van tekst, terwijl bij GPT-4 ook afbeeldingen mogelijk zijn. Apple gebruikte hierbij screenshots en merkte dat het aloude gezegde “een plaatje zegt meer dan duizend woorden” ook hier geldt: de modellen presteerden volgens Apple een stuk beter.

Apple zegt dat het kleinste reALM-model prestaties haalt die vergelijkbaar zijn met GPT-4 en dat de grotere reALM-modellen het aanzienlijk overtreffen. Bij Apple’s systeem zijn minder parameters nodig voor het parsen van contextuele data. Apple’s model laat zien dat het geven van commando’s aan Siri sneller en efficiënter kan verlopen door de gegeven context om te zetten in tekst, die gemakkelijker te ontleden is door een Large Language Model. Dat Apple’s model beter presteert, komt volgens de onderzoekers dat GPT-4 afhankelijk is van het verwerken van afbeeldingen om informatie op het scherm te begrijpen.

AI-functies op het toestel zelf

Apple wilde hiermee aantonen dat het mogelijk is om een on-device systeem te ontwikkelen dat net zo goed presteert als de online modellen. Voor Apple is dit belangrijk om de privacy van gebruikers te kunnen garanderen. Gebruik je het systeem bijvoorbeeld voor gezondheidsvragen, dan wil je niet dat jouw medische details in een online systeem terechtkomen, ook al wordt het alleen voor trainingsdoeleinden gebruikt.

Hopelijk gaan we bij de aankondiging van iOS 18 op 10 juni meer daarover horen en kunnen we het ook op korte termijn in het Nederlands gebruiken en niet alleen in het Engels en Chinees. Ook is het nog maar de vraag of Apple meteen de grotere on-device modellen gaat inzetten, of van start gaat met kleinere modellen, die minder indrukwekkende prestaties leveren.

Taalfout gezien of andere suggestie hoe we dit artikel kunnen verbeteren? Laat het ons weten!

Het laatste nieuws over Apple van iCulture

- Hierom gaat Apple vandaag in beroep tegen de boete van €500 miljoen voor overtreden van Digital Markets Act (07-07)

- De Europese verpakking van iPhones en iPads heeft vanaf vandaag iets extra's (20-06)

- Nederlandse kabinet stelt richtlijnen op voor smartphone- en social mediagebruik kinderen: dit staat erin (17-06)

- Xcode 26 krijgt ondersteuning voor AI-modellen: zo wordt ontwikkelen eenvoudiger (11-06)

- Jony Ive slaat handen ineen met OpenAI: komt er een nieuwe iPhone-concurrent aan? (22-05)