Apple heeft een onderzoeksartikel gepubliceerd over een manier om activiteiten te herkennen met sensordata. Je iPhone zit vol met sensoren die allerlei gegevens kunnen registreren. Denk aan de bewegingssensor, waarmee de iPhone al weet of deze plat of tafel ligt of dat je deze net opgepakt hebt. Een nieuw onderzoek laat zien dat grote taalmodellen (LLM’s) dit soort informatie kan gebruiken om beter te begrijpen wat je precies op je iPhone aan het doen bent.

Wat onderzoekt Apple precies?

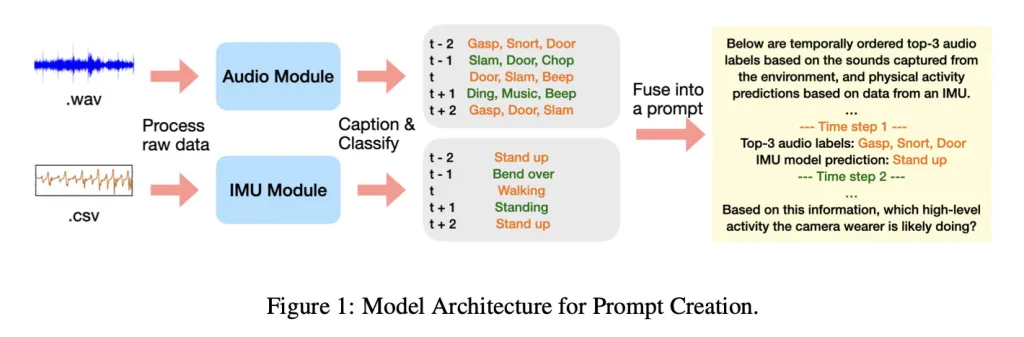

Apple onderzoekt of grote taalmodellen (LLM’s) activiteiten kunnen herkennen door korte beschrijvingen van geluiden (audio‑captions) te combineren met eenvoudige bewegingslabels uit een IMU (accelerometer/gyroscoop). In het paper “Using LLMs for Late Multimodal Sensor Fusion for Activity Recognition” voeren de onderzoekers per tijdstap deze samengevatte signalen aan het LLM, met de nadrukkelijke instructie om over mogelijke fouten heen te redeneren. De testset komt uit Ego4D, een first‑person dataset met alledaagse situaties zoals koken, afwassen, tv kijken, een boek lezen of sporten.

In plaats van één zwaar, speciaal getraind multimodaal model laten ze eerst kleine, bron‑specifieke modellen hun werk doen – een audiomodel maakt korte tekstbeschrijvingen van geluiden en een bewegingsmodel (op basis van accelerometer en gyroscoop) geeft simpele actielabels – waarna een groot taalmodel (LLM) die stukjes informatie logisch samenvoegt. Deze aanpak heet “late fusion” en heeft geen invloed op de privacy.

Deze aanpak vraagt minder taak‑specifieke training: het LLM hoeft niet eerst expliciet te leren hoe audio en beweging samenkomen, maar gebruikt algemene wereldkennis en redeneervermogen om tot een plausibele activiteit te komen. Dat maakt het flexibel én efficiënter. Daarnaast is het privacyvriendelijker: het taalmodel werkt met samenvattingen in plaats van ruwe audio of video, waardoor het minder gevoelig is voor persoonlijke details. Omdat je bestaande, kleine bronmodellen kunt combineren zonder alles in één grote multimodale architectuur te gieten, bespaar je bovendien geheugen en rekenkracht.

Hoe zijn de resultaten van dit onderzoek?

In de onderzoeken maakte Apple gebruik van twee scenario’s:

- Closed‑set: het LLM kiest uit een lijst van 12 activiteiten.

- Open‑ended: het LLM formuleert zelf de activiteit, die vervolgens wordt gemapt naar de dichtstbijzijnde klasse.

De uitkomsten zijn veelbelovend. Zonder taak‑specifieke training (zero‑shot) presteert het LLM al duidelijk boven toeval (zonder duidelijke oorzaak); met één voorbeeld (one‑shot) gaat de score verder omhoog. Audio‑captions bleken het meest informatief, terwijl ruwe audio‑labels en eenvoudige IMU‑labels (beweging) soms misleidend kunnen zijn bij fouten, dit is tevens de reden waarom tijdsoverkoepelend redeneren cruciaal is. Extra meetbare context (synthetisch, zoals indoor/outdoor of hartslagzones) helpt merkbaar. Bij sportieve of intensieve activiteiten voegt IMU‑informatie waarde toe, al was de gebruikte IMU‑classifier beperkt in zijn uitgangsruimte.

Wat ga je hier als gebruiker van merken?

De echte meerwaarde zit in functies die nuanceren wat je devices al meten. Deze methode kan gezondheid‑ en fitnessfeatures slimmer maken wanneer ruwe sensordata op zichzelf niet genoeg context biedt. Denk aan een situatie waarin je Apple Watch en iPhone wel beweging en geluid registreren, maar een LLM door omgevingsgeluid en bewegingspatronen beter begrijpt of je aan het koken bent, aan het afwassen of een workout doet en daarop je feedback, suggesties of logging verfijnt.

Apple doet regelmatig dergelijke onderzoeken, vaak bedoeld om functies in iOS beter en slimmer te maken. Het is dan ook goed mogelijk dat dit onderzoek in de toekomst leidt tot het beter functioneren van bepaalde functies. Een goed voorbeeld is de handenwasfunctie: zowel de bewegingen die je met je handen maakt als het geluid van een lopende kraan, zorgt ervoor dat er op de Apple Watch automatisch een timer in beeld verschijnt die je helpt om 20 seconden lang je handen te wassen.