Vorige week was Apple in het nieuws omdat medewerkers voortaan AI-onderzoek mogen publiceren. Dat beloofde Ruslan Salakhutdinov, die tegenwoordig directeur van Apple’s AI-onderzoek is. Tijdens dezelfde gesloten bijeenkomst vertelde Salakhutdinov op welke gebieden Apple zich gaat richten. Een deel van de presentatie kwam bij Quartz terecht, waardoor we beter inzicht krijgen in Apple’s ambities rond kunstmatige intelligentie en machine learning.

Aan deze AI-onderwerpen werkt Apple

Dat Apple AI-onderzoek gaat publiceren is een grote stap voor het bedrijf, dat normaal erg gesteld is op geheimzinnigheid. Apple houdt nieuws en productontwikkeling het liefst binnen het bedrijf, maar daarmee helpen ze de wetenschappelijke wereld niet vooruit. Het hoofd van Facebook’s AI-onderzoek zei het eerder dit jaar zo: “Wanneer je AI onderzoek geheim houdt, ga je achter lopen.”

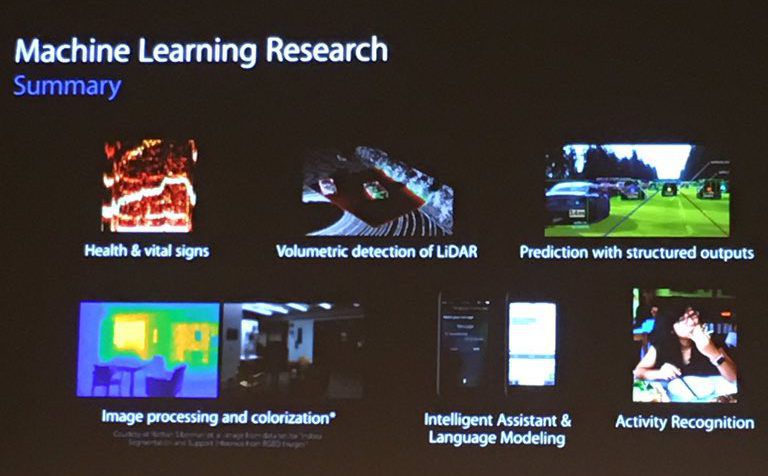

De nieuw gelekte informatie geeft aan dat Apple ongeveer aan dezelfde problemen werkt als de concurrentie. Ze gebruiken machine learning om beelden te herkennen en verwerken, persoonlijke assistenten te verbeteren en om het gedrag van gebruikers te herkennen.

Zo waren er op de slides auto’s te zien met de text ‘Volume waarnemen met LiDAR’ (een soort radar) en verderop is er een afbeelding met auto’s te zien. Onder dat beeld staat een andere uitdaging van Apple: voorspellingen doen aan de hand van gestructureerde informatie.

Neurale netwerken voor snellere afhandeling

Ook was te zien hoe Apple met neurale netwerken hun technieken sneller en efficiënter maakt. Dat is voor Apple essentieel, omdat sommige toepassingen van machine learning op de iPhone gedaan worden. Denk bijvoorbeeld aan de Foto’s-app. In iOS 10 gebruikt Apple machine learning om objecten en scenes te herkennen in je persoonlijke foto’s. Die processen werken allemaal lokaal op het toestel en herkennen duizenden verschillende objecten.

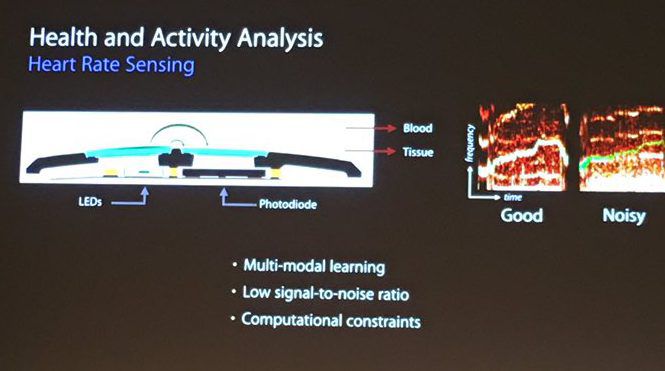

Verder was te zien hoe Apple machine learning inzet voor analyses van gezondheidsdata. Eén slide liet zien hoe ze hartslag meten, met technieken die waarschijnlijk worden gebruikt in de Apple Watch. De illustratie van de hartslagsensor lijkt op die van de Apple Watch en onder de afbeeldingen meldt Apple dat er ‘beperkingen in computerkracht’ zijn. Die beperkte computerkracht geldt waarschijnlijk voor de iPhone of Apple Watch.

‘Twee keer zo snel als Google’

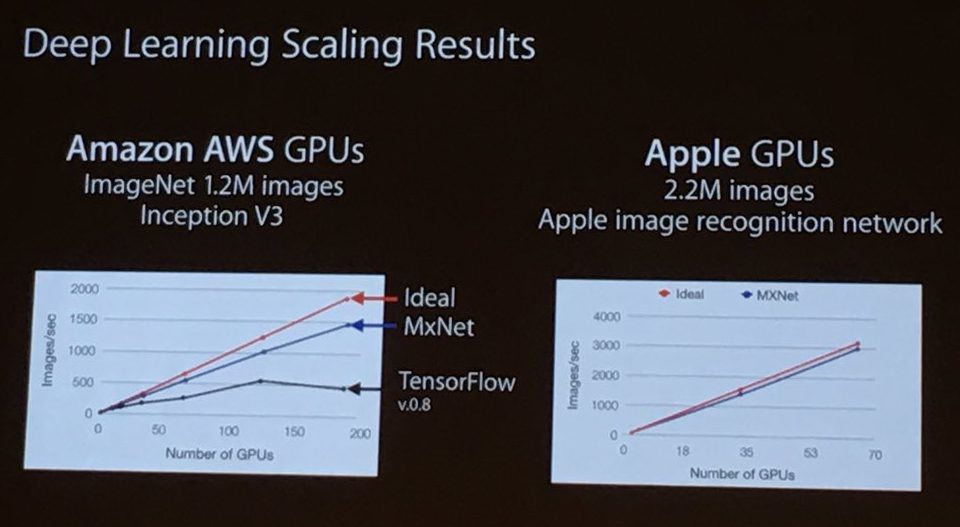

Apple schept in de presentatie op dat ze twee keer zoveel foto’s per seconde kunnen verwerken dan Google. Apple kan 3000 beelden per seconde verwerken terwijl Google’s algoritme er maar 1500 haalt.

Het is niet bekend welke computers Apple hiervoor gebruikt heeft. Voor Google’s metingen is een industrie-standaard gebruikt van Amazon. Mogelijk gebruik Apple krachtiger computers.

Taalfout gezien of andere suggestie hoe we dit artikel kunnen verbeteren? Laat het ons weten!

Het laatste nieuws over Apple van iCulture

- 'EU keurt Apple's plannen om iPhone NFC-chip open te stellen binnenkort goed' (20-04)

- Apple wilde 100.000 bruikbare iPhones vernietigen, maar dat liep anders (18-04)

- Eerste NES-emulator in de App Store verschenen (en alweer verwijderd door ontwikkelaar) (17-04)

- Apple waarschuwt gebruikers in 92 landen voor spyware (11-04)

- 'Apple wil meebieden voor Nederlandse Formule 1-rechten' (10-04)

Apple

Apple is het bedrijf achter de iPhone, iPad, Mac, Apple Watch en de andere mooie producten die we op iCulture bespreken, maar ook de vele diensten zoals de App Store, Apple Music, Apple Pay, iCloud en meer. Lees meer over Apple's CEO Tim Cook en de andere Apple-topmensen, hoe je contact opneemt met Apple Support en de Apple Stores in Nederland en België.

- Alles wat je wil weten over Apple

- Apple Park, het hoofdkantoor van Apple

- Apple's managementteam

- Alles over Apple CEO Tim Cook

- Alles over de iPhone

- Alles over de iPad

- Alles over de Apple Watch

- Alles over de MacBook

- Contact opnemen met Apple Support

- Apple Stores in Nederland: Amsterdam, Haarlem, Den Haag

- Apple Stores in België: Brussel en verder

- Alles over Apple's diensten

Reacties: 0 reacties